得益于AI算力的需求,HBM成为香饽饽。

近日据韩国 Chosun Biz报道,NVIDIA已经向SK海力士、美光,交付了700亿至1万亿韩元的预付款。虽然预付款未作具体说明,但业界普遍认为是NVIDIA为保证今年要上市的GPU产品相应所需HBM3E的物量供应。

同样在需求激增的市场环境下,存储三大巨头也在争相推进HBM生产。近期,三星、SK海力士正计划将HBM产量提高至2.5倍,美光则将在今年推出8层堆叠的AI专用HBM3E内存。对于HBM4,这三家企业也是当仁不让,相继确认开发和正式推出的时间。

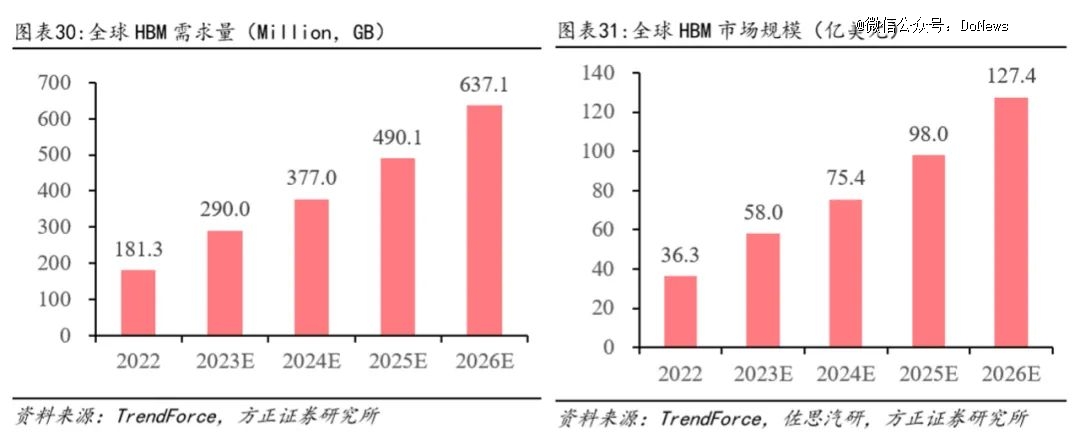

TrendForce预估,2024年全球HBM的位元供给有望增长105%;HBM市场规模也有望于2024年达89亿美元,同比增长127%;预计至2026年市场规模将达127.4亿美元,对应CAGR约37%。

01.是谁在推动HBM市场?

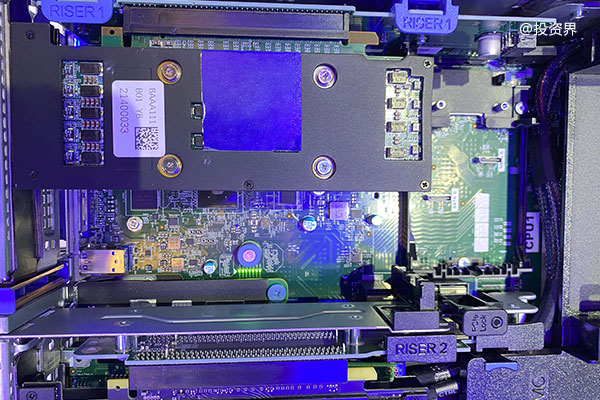

HBM(High Bandwidth Memory,高频宽存储器)是一种基于3D堆栈工艺的高性能DRAM,通俗来讲,就是先将很多DDR芯片堆叠在一起后,再与GPU封装在一块。正是基于Interposer中介层互联实现了近存计算,以及TSV工艺的堆叠技术,让HBM打破了内存带宽及功耗瓶颈,成为AI训练硬件的*。

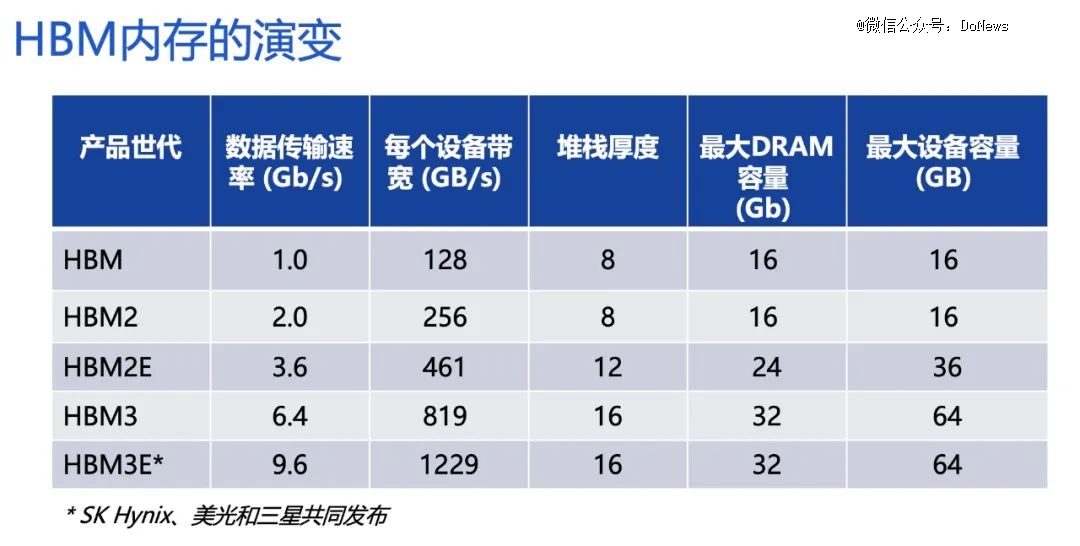

其实HBM应用已有几年的时间,自2014年*硅通孔HBM产品问世至今,HBM技术已经发展到第五代,其中HBM3E是HBM3的扩展版本,依次类推,HBM4将是第6代产品。从HBM内存的演变来看,最新的HBM3带宽、堆叠高度、容量、I/O速率等较初代均有多倍提升。

图源:Rambus

这也恰恰是AI算力所需要的。

根据OpenAI的数据,自2012年以来,*规模的AI训练所使用的计算量以每年10倍的速度增长。OpenAI的ChatGPT充分体现了AI训练数据集的增长。2022年11月发布的GPT-3,使用1750亿个参数构建,去年3月发布的GPT-4使用超过1.5万亿个参数。

面对这波AI浪潮, NVIDIA 创始人兼首席执行官黄仁勋曾表示:“大语言模型初创公司、消费互联网公司和全球云服务提供商都已率先行动起来,下一波浪潮蓄势待发。”当然,算力作为人工智能中关键一环,人工智能芯片供应商扮演着重要角色。

NVIDIA2023年的高端AI阵容使用HBM,包括A100/A800和H100/H800等型号。此外,NVIDIA还再进一步完善其产品组合,发布了配备HBM3E内存的H200 GPU以及GH200超级芯片,相关系统预计将于今年第二季度上市。据了解,以GH200超级芯片为例,HBM3E内存比当前HBM3快50%,可提供总计10TB/s的带宽,这使得NVIDIA GH200 Grace Hopper平台能够运行比上一版本大3.5倍的模型,同时凭借快3倍的内存带宽提升性能。

与NVIDIA“神仙打架”的AMD,在去年12月“Advancing AI”活动上,正式发布了AI旗舰GPU加速器AMD Instinct MI300X,更是宣称性能比英伟达的H100高出60%。据了解,MI300X采用HBM3内存,容量最高192GB,比前代MI250X(128 GB)高50%。该内存将提供高达5.3TB/s的带宽和896 GB/s的Infinity Fabric带宽。

同样想分AI一杯羹的,还有英特尔。据外媒报道,英特尔计划2024年发布Gaudi 3,配备最高128GB的HBM3E RAM,大幅提升AI学习和训练性能。

谁能成为NVIDIA的替代者,还需要市场的反馈。

毋庸置疑的是,这场AI竞争需要极高的算力需求,但因产能受限,供不应求成为现状,进而使HBM价格高增,HBM市场规模高速增长。

图源:方正证券

方正证券报告指出,从成本端来看,HBM平均售价至少是DRAM三倍;而此前受ChatGPT的拉动同时受限产能不足,HBM价格一路上涨,与性能最高的DRAM相比,HBM3的价格上涨了五倍。

02.HBM市场三分天下

在NVIDIA、AMD、英特尔三家互搏的同时,存储厂商也没有闲着,生产/扩产成主旋律。

从2013年宣布成功研发HBM1,到2019年开发出世界最快的高带宽存储器HBM2E,再到2021年10月开发出全球*HBM3 DRAM,再到去年开发出全球最高规格HBM3E,SK海力士一直是HBM行业的领军企业。

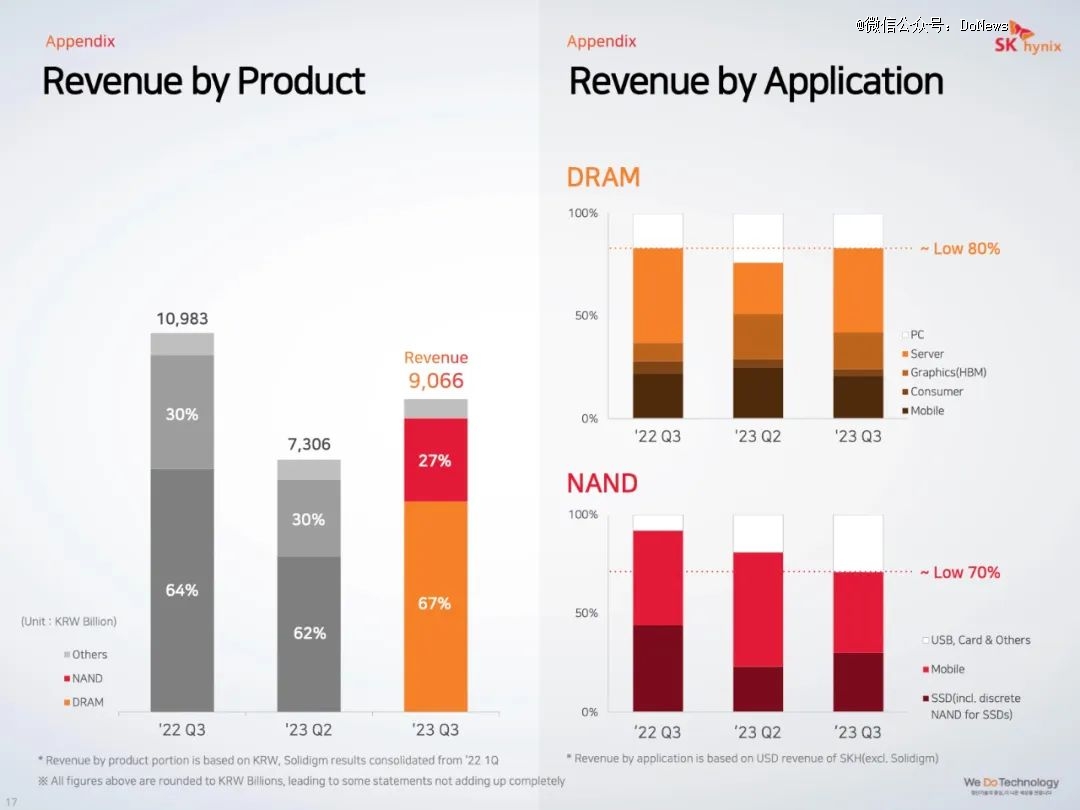

值得关注的是,SK海力士2023年*季度由盈转亏的DRAM仅在两个季度后扭亏为盈。

SK海力士解释道:“因高性能半导体存储器产品为中心的市场需求增加,公司业绩在*季度低点过后持续改善,特别是面向AI的代表性存储器HBM3、高容量DDR5 DRAM和高性能移动DRAM等主力产品的销售势头良好,与上季度相比营业收入增长24%,营业损失减少38%。”SK海力士表示,将以第四代10纳米级(1a)和第五代10纳米级(1b)DRAM为中心的生产线转换,同时扩大对HBM TSV1技术的投资。

图源:SK海力士财报

据悉,SK海力士已决定在2024年预留约10万亿韩元(约合76亿美元)的设施资本支出聚焦于为高附加值DRAM芯片扩建设施,包括HBM3、DDR5及LPDDR5,以及升级HBM的TSV先进封装技术两方面。SK海力士首席执行官Jeong-ho Park透露,预计到2030年公司HBM出货量将达到每年1亿颗。

此外,SK海力士在公司年度高层改组中,新成立的AI基础设施部门将整合分散在公司内部的高带宽内存(HBM)能力。该部门还将主导新一代HBM芯片等人工智能技术的发展,寻找并开发新市场。不难看出,SK海力士对HBM的高期望。

以TrendForce报告统计数据为参考,2022年SK海力士占据了HBM全球市场规模的50%,三星紧随其后,占比为40%。

二者皆得益于存储市场回暖的影响,从三星电子去年第三季度财报数据来看,出现了复苏的迹象。数据显示,三星电子第三季度存储业务环比增长17%至10.53万亿韩元,存储业务所在的DS部门经营亏损3.75万亿韩元,但较上季度经营亏损4.36万亿韩元有所减少。

图源:三星财报

面向未来存储市场增长的预期,三星电子收购了三星显示(Samsung Display)天安厂区内部分建筑及设备,用于HBM生产。三星电子计划在天安厂建立一条新封装线,用于大规模生产HBM,预计投资7000亿-1万亿韩元。同时,三星正在投入8层、12层HBM3量产,并开始供应8层HBM3E样品。

据悉,之前英伟达的HBM一直由SK海力士*供应,由于需求极为庞大,三星据称也已通过质量评估,即将加入供应商队列。也有消息称,三星电子计划从今年1月开始向英伟达供应HBM3。

对2023年HBM市场份额,TrendForce预测,SK海力士和三星的HBM份额占比约为46-49%。这一数据也凸显出,SK海力士和三星的势均力敌。

如果说三分HBM市场的“天下”,最后一家企业则是美光(Micron)。美光虽然2022年市场份额仅为10%,但也不甘于落后。美光科技台中四厂正专攻HBM生产,计划将于今年量产第五代HBM3E产品。

就供应链而言,业界预测,这三家公司将为英伟达即将推出的H200和B100所需的HBM3E供应展开激烈竞争。

小结

智能语音、ChatGPT、智能驾驶等智能化应用逐渐渗透到我们的生活中,带来了巨大的存储芯片需求。去年下半年存储芯片市场价格的反弹信号,让行业人士看到“曙光”。

从存储产业链看,SK海力士、三星等大厂采用IDM模式,一手包办了芯片的设计、制造和封测。而国内市场,存储产业链还是比较边缘,主要处于HBM上游设备和材料供应环节。但国内相关HBM概念股也有所受益。有消息称,相关厂商也在积极布局高端存储产品,以求适应市场需求和技术演进。