“切勿错过AI的决定性时刻!”

当黄仁勋在英伟达GTC 2023上提出这个观点时,可能很多和我一样的普通人并没有把它放在心上,毕竟当时的AI应用少之又少,懂得在家里部署本地AI绘画的只有极少数数码爱好者,而相对大众的大语言模型给人们带来的也只有一时的新鲜感。

当然,现在看来,那个时间点可能确实是AI的决定性时刻。

今天凌晨,被誉为AI风向标的英伟达GTC 2024在加州圣何塞SAP中心正式举行,万众瞩目的英伟达创始人兼执行长黄仁勋登台发表主题演讲《见证AI的变革时刻》。老黄诚不欺我,我们确实见证了一场AI的变革时刻。

在这场两个小时的演讲中,黄仁勋公布了该公司迄今为止最强的AI加速卡——Blackwell GB200超级芯片系统,预先配置好整套系统的完整版GB200服务器,以及英伟达在AI软件(NIM微服务)、Omiverse云(模拟地球)、具身智能(机器人)等技术方面的最新进展。

老黄带来的这一波AI芯片基础设施到底有多强大?将给AI大模型产业带来什么改变?一起来看。

Blackwell GB200:

最强AI加速卡

在人工智能领域,计算速度是至关重要的。为了在最短的时间里,完成大量同质化数据的并行运算,就需要给GPU投喂大量的数据,训练出一个复杂的神经网络模型,可以说GPU就是AI大模型训练平台的基石,甚至是决定性的算力底座。

因此,本次演讲的主角自然是英伟达的老本行「Blackwell B200」GPU 芯片。

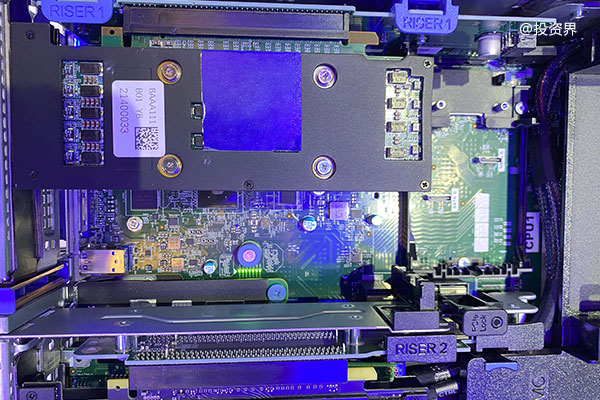

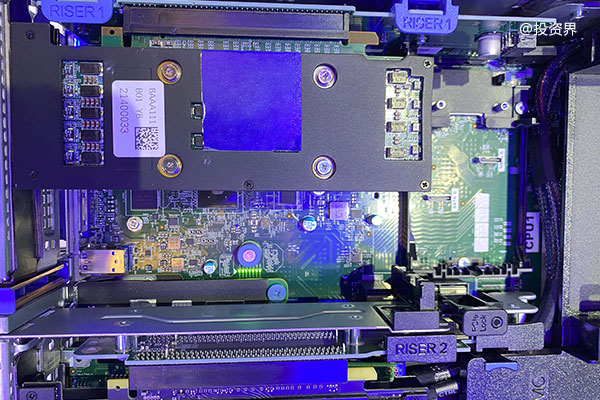

作为NVIDIA Blackwell架构*新产品,Blackwell B200基于台积电的4nm工艺打造,采用了将两个die连接成一个GPU的双芯设计,因此每个GPU芯片上拥有2080亿个晶体管。

比起上一代GH100 GPU上的800亿个晶体管,Blackwell B200 GPU算是一次相当大的突破,甚至还契合了摩尔定律,即「集成电路上可容纳的晶体管数目大约每隔18个月便会增加一倍」。

黄仁勋表示,在这样的架构升级下,Blackwell B200的AI性能可达20PFLOPS,而 H100仅为4PFLOPS,理论上可以为 LLM(大语言模型)的推理提升 30 倍的工作效率,额外的处理能力将使人工智能公司能够训练更大、更复杂的模型。

更离谱的是,在B200的基础上,老黄还推出了完全体AI芯片组——Blackwell GB200,由两个Blackwell B200 GPU 和一个基于Arm的Grace CPU组成。

在参数为1750亿的GPT-3 LLM基准测试中,英伟达称GB200的性能是H100的7倍,而训练速度是H100的4倍。

这AI性能,已经形成代差水平了。

当然,如果GB200还不能满足你的需求的话,英伟达还准备了一系列由Blackwell GB200组成的服务器阵列,最高可以实现由72片B200 GPU组成的GB200 NVL72 系统,FP8精度的训练算力高达720PFlops,达到了可以和前代DGX SuperPod超级计算机集群的水平。

更重要的是,与H100相比,它可将成本和能耗降低到原来的 25 分之一。

在今年年初的时候,美国知名杂志《纽约客》报道,ChatGPT每日耗电量或超过50万千瓦时,相当于美国家庭平均用电量的1.7万倍。正如马斯克所说,在可以预见的未来,电能短缺将成为制约AI发展的主要因素。

老黄明确表示,在此之前,训练一个1.8万亿参数模型需要8000个H100 GPU和约15兆瓦的功率,如今2000个B200 GPU就可以做到这一点,而功耗仅为4兆瓦。

如此惊人的参数,让老外直呼,“摩尔定律已被改写!”

可以预见,为了继续吸引国内市场的客人,黄仁勋很可能在未来推出采用新一代AI图形处理器架构的*版AI加速卡Blackwell B20 GPU。

只是在美国商务部明确算力出口限制的情况下,这颗中国*版GPU能带来多少产能上的提升,又能否和国产替代AI加速卡之间达成良性竞争,只能说目前一切都是未知之数。

从模拟地球

到人形机器人

从整个世界的狂热程度来看,生成式AI浪潮的到来已凝聚了广泛共识。那么我们到底能利用AIGC来做些什么呢?老黄今天给出了一些标准答案。

不知道大家有没有玩过一款叫做《模拟地球》的游戏,开发商MAXIS在当时性能相对贫乏的电脑上创造了一个微缩地球,让玩家扮演神明的角色,管理整个地球的地形、大气、生物、文明等内容,建造一个生命繁荣的惑星。

(图源:MAXIS工作室)

现在,英伟达利用大模型的能力,正试图打造出地球的数字孪生——Earth-2。

Earth-2是一个在英伟达Omniverse中以百万倍的速度运行Modulus创建的AI物理环境,旨在实现数据中心规模的全球模拟环境,最终利用云计算和人工智能技术来模拟和可视化天气情况。

利用传统的天气模型结合英伟达的气象模型,最高能够实现探索数百公里甚至数千公里面积范围的预报,提供诸如台风影响的侵袭范围,从而*程度降低财产的损失,未来这项技术预计也将向更多国家和地区开放。

没有错,当年PS3模拟地球的梗,如今似乎要成真了。

接下来,我们聊聊人形机器人。

近些年来,人形机器人成为了科学业界一个比较流行的研究趋势,除了马斯克那备受关注的Tesla Optimus,波士顿动力、Agility Robotics、优必选、小米、智元机器人、科大讯飞等中外企业也在这条道路上钻研着。

随着大模型不断的迭代升级,智能泛化能力的飞速提升,业内有不少人看到了人形机器人的潜在前景,相较于用反复调试的各种数据去驱动机器人,不如试着用大模型用作大脑,机器人充当躯壳,让大模型通过感知、运动和环境交互来获取信息、做出判断并采取行动。

而这,便是人工智能的*形态之一——具身智能。

为此,英伟达在今天推出了世界*人形机器人通用基础模型——Project GR00T,该模型驱动的机器人将能够理解自然语言,并通过观察人类行为来模仿动作,用户可以在此基础上教会其快速学习协调各种技能,以适应现实世界并与之互动。

老黄坚信,具身智能将引领下一波人工智能浪潮。

看到这里小雷只想说,优必选们,赶紧去跟英伟达合作吧,你们的机器人“身体”,必须在英伟达的Project GR00T“大脑”加持下,才能成为真正的智能机器人。随着Project GR00T的出现,真正的机器人时代可能要来了,这也是AI的最*应用:让人工智能具象成为“人”。

十年夙愿终成真

英伟达CUDA真“酷酷哒”

在GTC 2024开幕演讲上,老黄回顾了一下英伟达的发展史。

2014年,黄仁勋首次强调机器学习的重要性,并且提出了CUDA(通用计算平台)的概念,在许多人还在把英伟达当作「游戏显卡」的制造商时,它们已经走在了 AI 变革的最前沿。

然而当年,CUDA的应用场景主要是科学计算,就是类似于气候模拟、物理模拟、生物信息学等专业研究,应用场景很有价值,但却狭窄。正因为此,英伟达的CUDA一直没有打开市场,带给英伟达的回报无法与对应的巨量研发投入匹配。黄仁勋每年都需要向董事会解释,为什么英伟达要坚持做CUDA?——可能当时老黄也不知道,英伟达的CUDA会在未来几年,先后迎来区块链“挖矿”、AI大模型计算等计算场景,真实泼天富贵。

短短两年时间,英伟达通过H100、H200 芯片,缔造了万亿AI帝国,市值已超越亚马逊等传统豪强,按照这样的势头,在可见的未来,超越苹果、微软成为世界头号巨头也不是没有可能。

现在,英伟达的“卡”供不应求,不只是字节、百度等中国科技巨头在抢着囤卡以应对极端情况,硅谷科技巨头如微软、Meta,也全都在找老黄买卡。

如今,尽管入局AI以及AI芯片的玩家越来越多,部分贸易政策的冲突也让老黄变得有些束手束脚,但从整场大会演讲来看,他依然对全新发布的B200、GB200颇具信心,对于整个世界被AI赋能的愿景更是坚定不移。

在被称为AI应用元年的2024,英伟达的CUDA(通用计算平台)正如其名,变得通用起来,从大语言模型、对话式AI、边缘计算等底层技术,到智能座舱、自动驾驶、人形机器人等应用场景,再到AI手机、AI PC、AI家电、AI搜索、AI绘画等应用,以及未来的气候预测、计算光刻与6G网络,AI正无处不在,英伟达的计算也无处不在,成为“通用计算”。

英伟达的CUDA,真的很“酷哒”。