2023过去,当我们回顾这一年的最受产业关注的芯片,相信大多数人会将票投向GPU。2023年中,我们总能听到“GPU紧缺”、“英伟达狂飙”、“黄仁勋分享成功秘诀”。

无可否认,2023年生成式AI的热潮无边无际,全球高科技公司都涌入了AI的军备竞赛。随之带来的是算力告急、全球疯抢GPU。

1、全球最火的GPU

2023年层出不穷地传出,人工智能AI大模型的消息。OpenAI、百度、谷歌、腾讯都在搭建属于自己的大模型。对于这些五花八门的大模型,我们不多赘述,但大模型的搭建,最需要的就是GPU,而2023年需求量*的GPU不外乎:A100/H100。

首当其冲的就是A100GPU。OpenAI使用的是3,617台HGXA100服务器,包含近3万块英伟达GPU。国内云计算相关专家认为,做好AI大模型的算力*门槛是1万枚英伟达A100芯片。

TrendForce研究则显示,以A100的算力为基础,GPT-3.5大模型需要高达2万枚GPU,未来商业化后可能需要超过3万枚。

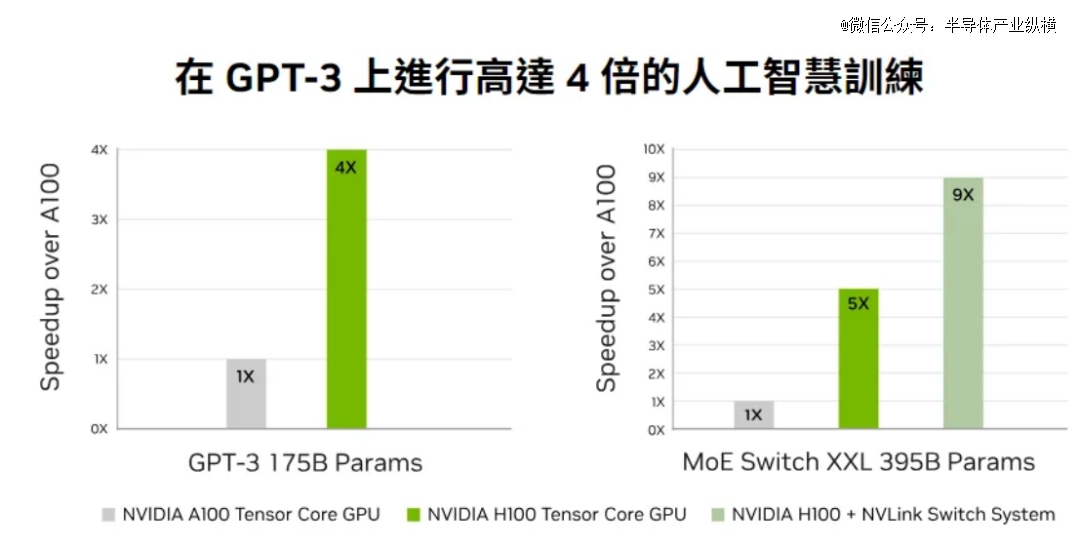

H100也是业内追求的对象。H100于去年9月量产,由台积电4N工艺代工。相较于前任A100,H100单卡在推理速度上提升3.5倍,在训练速度上提升2.3倍;如果用服务器集群运算的方式,训练速度更是能提高到9倍,原本一个星期的工作量,现在只需要20个小时。

考虑到整体系统成本,H100每美元产生的性能比A100还要高4到5倍之多。与A100相比,H100的单卡价格更贵,但是由于其训练、推理效率增加,成为了*性价比的产品。

正因如此,科技大厂各个都抢着要买英伟达H100GPU,或者更准确地说,是英伟达的8-GPU HGX H100SXM服务器。

英伟达成为了最受关注的卖铲人。针对中国市场,还按照A800操作模式(A100芯片的降维版本),推出了完全符合出口规定的H100的降维版本芯片。

2、热情的买家

“GPU就是新时代的比特币。”OpenAI首席科学家IlyaSutskever将这句话写在他个人的X账号上。在算力激增的背景下,英伟达的GPU成为了“硬通货”。

夸张的是,甚至有海外初创企业开始利用GPU进行抵押融资,一家硅谷的创业公司使用H100拿到了23亿美元的债务融资。

购买H100和A100的公司有三种。*种,是需要超过1000张的公司,包括训练LLM的创业公司,如OpenAI、Anthropic;云服务提供商,如谷歌云、AWS、腾讯云;其他大公司,如特斯拉。第二种,是需要超过100张的公司,也就是对开源模型进行大量微调的初创公司。第三种,需要10张的公司,就是大部分创业公司和开源势力,热衷使用大模型的输出微调小模型。

这些买家需要多少GPU呢?OpenAI可能需要5万张、Inflection要2.2万张、Meta需要2.5万张、大型云厂商(Azure、GoogleCloud、AWS、Oracle),每家可能需要3万张,Lambda和CoreWeave以及其他私有云可能总共需要10万张,Anthropic、Helsing、Mistral、Character,每家可能要1万张。

仅仅这几家公司,就已经需要43.2万张H100,如果以每块约3.5万美元计算,GPU的价值约为150亿美元。而这还没有包括字节、百度、腾讯等国内公司。

在AI大模型竞争上,榜上有名的几个国家:中国、美国、沙特阿拉伯、阿联酋,都是英伟达的座上宾。

沙特阿拉伯已通过公共研究机构阿卜杜拉国王科技大学(Kaust)购买了至少3000块英伟达的H100芯片。这些芯片将于2023年底全部交付,总价值约为1.2亿美元,用于训练AI大模型。

阿联酋也获得了数千颗英伟达芯片的使用权,并已推出自己的开源大语言模型“Falcon40B”,“Falcon40B”使用了384个A100芯片进行训练。

3、GPU的出货量

英伟达H100的出货量也备受关注。研究机构Omdia披露,英伟达在2023年第二季度的H100出货量为900吨。按照单片H100GPU的重量约为3千克,那么英伟达在二季度售出了约30万片H100。

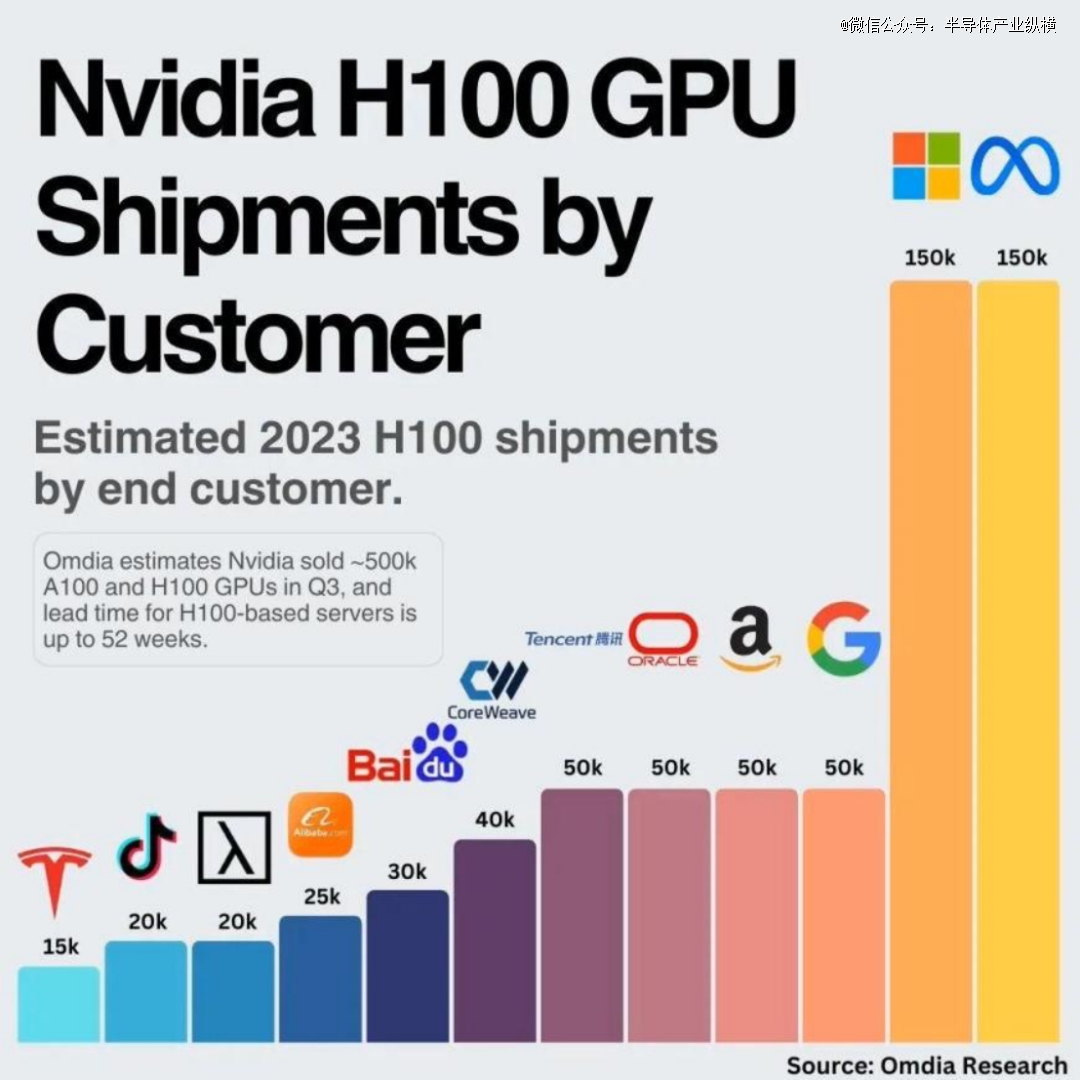

到了三季度,英伟达大约卖出了50万台H100和A100 GPU。每家能够分到的GPU数量有限,Meta和微软各自采购了15万个H100GPU,谷歌、亚马逊、甲骨文和腾讯则各采购了5万片。

如此庞大的GPU需求量,导致基于H100的服务器需要36~52周的时间才能交付。按照英伟达官方的说法,2024年一季度之前的GPU芯片早已全部售罄。

业内预估,明年英伟达的出货量将达到150万-200万颗。

4、2024,GPU能降价吗?

GPU能否降价,还要看明年的供需情况。上图是GPUUtils列出的目前对GPU市场供需变化最有直接影响的科技公司,包括了:开发出Chat-GPT的OpenAI、台积电、微软、Meta以及成立仅仅一年便募得13亿美元资金的AI新创Inflection。

买方

有的人不想买。谷歌、Meta都觉得英伟达的GPU太贵了。

Meta最近已经宣布构建了自己的DLRM推理芯片,并且得到广泛部署。Meta大大方方承认,自己即将发布的AI芯片并不能直接替代英伟达的芯片,但是自研芯片可以降低成本。

就算在谷歌I/O开发者大会两个小时的演讲中,谷歌方面一直在赞赏英伟达的H100GPU芯片。这也不妨碍,谷歌开始“骑驴找马”,谷歌的云服务器上已经用上了自家TPU。

Google TPU v5e于2023年8月发布,成为人工智能硬件领域的强大力量,专为大型语言模型和生成式人工智能量身定制。与前代产品相比,TPUv5e的每美元训练性能显著提高2倍,每美元推理性能显著提高2.5倍,可大幅节省成本。其突破性的多片架构可实现数万个芯片的无缝连接,突破了以往的限制,为处理海量人工智能任务开辟了途径。

有的人不能买。中国是英伟达的第三大市场,占据其收入的1/5以上。随着美国政府宣布进一步禁止中国销售英伟达H800和A800芯片,卖不出去的GPU,必然会对英伟达产生负面影响。

此外,明年AI或许迎来退潮。2023年的AI热潮,除了大模型震惊业界外,炒作的因素也不在少数。毫无疑问,ChatGPT是2023年的世界顶流。因为它,OpenAI网站的流量在4月份就超过了18亿,进入了全球流量排名前20。然而,网络分析公司Similarweb公布的数据显示,在狂飙半年后,ChatGPT的访问量首次出现负增长,6月份的访问量环比下滑9.7%。

在大模型创业狂飙200多天后,探索者们的心态,从理想亢奋来到现实落地。大模型的维护依赖大量的高性能芯片,而单要建构、维护生成式AI工具的成本就非常巨大。这对于大公司而言还好,但是对于许多组织与创作者而言,这却是一笔难以负担的支出。

对于生产式AI,2024年还会再次迎来大众的检验。行业分析师认为,2023年关于生成式人工智能的炒作非常大,AI被过度吹捧,因为相关技术需要克服许多障碍才能将其推向市场。

退潮之后,能够剩下的高性能GPU需求还能有多少?

卖方

我们先来看看英伟达这个*的卖家。优先关注两个方面:能不能供应足够的GPU,明年是否有新品刺激市场需求。

*个供货方面,众所周知,英伟达只与台积电合作生产H100,台积电一共有4个生产节点是为5nm芯片提供产能:N5、N5P、N4、N4P。而H100只在N5或者是N5P的中的4N节点上生产,这是一个5nm芯片的增强型节点,同时英伟达还必须与苹果、AMD和高通共享这个节点的产能,至于A100显卡则是在台积电的N7生产线制作的。从短期的情况看,三星和英特尔都因为制程技术的问题,无法替英伟达缓解供应紧张的问题。因此,预计明年市场,英伟达的GPU供应仍会紧缺。

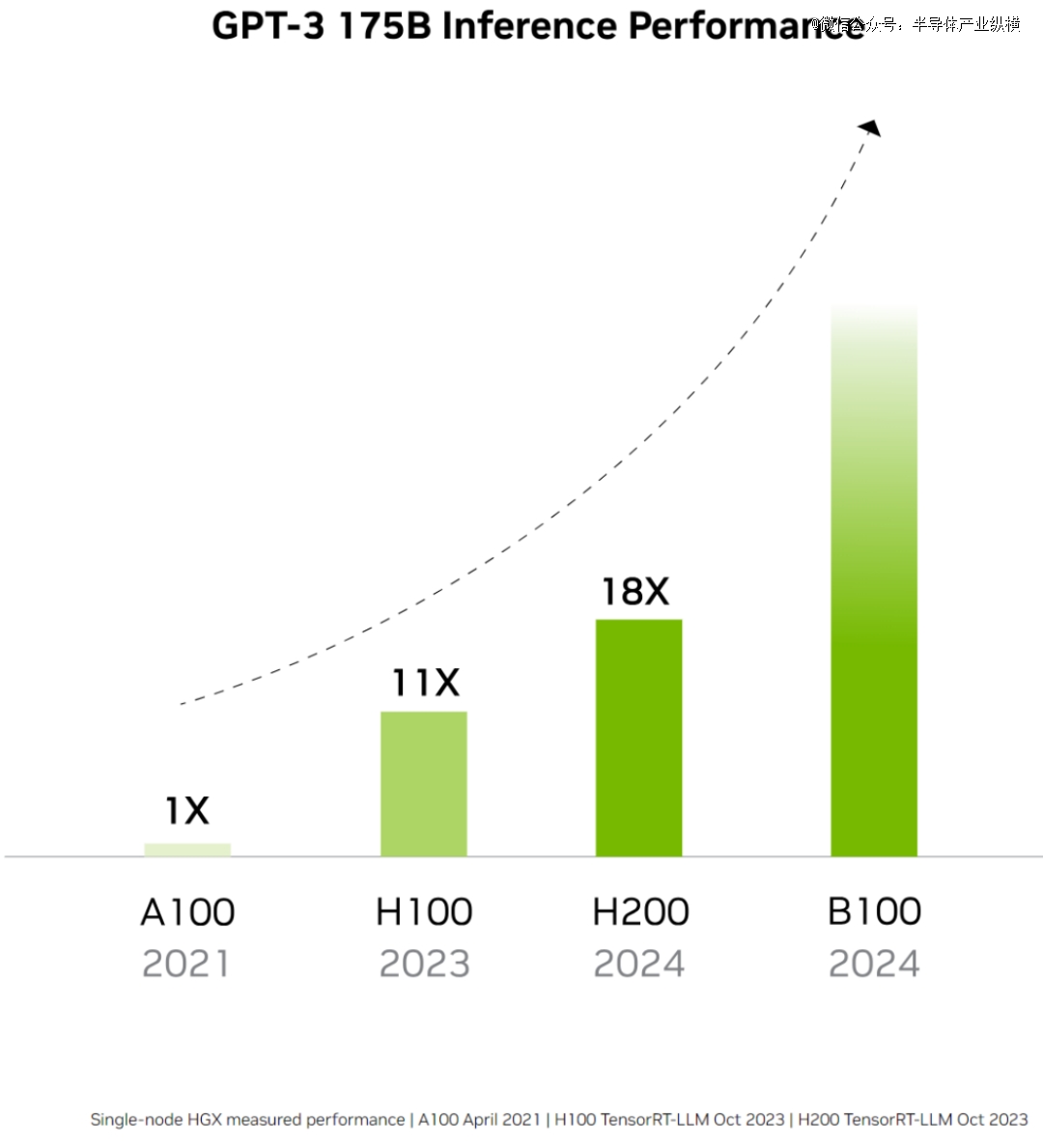

第二个新品方面,英伟达在2023年11月底时,发布了H100的下一代继承者——H200。表示在处理Llama2等LLM时,H200的推理速度比H100GPU提高了近2倍。从2024年开始,亚马逊网络服务、谷歌云、微软Azure和甲骨文云基础设施将成为首批部署基于H200实例的云服务提供商。尽管还没有公布H200的价格,但一定比H100目前每台2.5万美元至4万美元的价格更加昂贵。

从两个方面看,英伟达的GPU供需还存在较大的不确定性。不过。卖家市场,会有更多厂商加入。

明年GPU的另一大卖家,就是回过神来的AMD。

从最近的财报来看,AMD预计四季度GPU收入将达到4亿美元,到2024年底将超过10亿美元。其CEO苏姿丰对明年充满期待:“MI300将成为自2020年后,销售额达到10亿美元最快的产品。”

2023年11月,AMD正式发布了对标H100的产品——MI300。据AMD展示,由8块MI300X组成的服务器在大模型推理方面的表现,要比同样规模的H100速度最高提升1.6倍之多。对于AMD来说,这种直接对标,实属罕见。

有意思的是,Meta、微软和OpenAI公司在AMD投资者活动上表态,未来他们将会使用AMD最新的人工智能(AI)芯片InstinctMI300X。

不过,英伟达对AMD的对标也态度强硬,官方发布博客,驳斥AMD的评测不客观。英伟达表示,如果H100GPU使用了优化过的软件进行正确的基准测试,它的性能将大大超过MI300X。

由于MI300还未正式应用,对于我们对于AMD和英伟达之间的“官司”很难分说,但不论如何,AMD已经走到了高性能GPU的起跑线。

总而言之,2024年的GPU还充满变数。在AI大模型冷静后、在买家不想当冤大头后、在卖家越来越多后,GPU还会维持天价吗?相信各位看官心中自有答案。从市场的角度看,无论是当下多先进的技术,到最后终将会越来越普世。就看GPU玩家们,在2024年如何进攻战场了。