说起“存储”和“AI”,很多人会说存储对AI很重要,因为AI的发展是由海量数据支撑起来的,这就使得人们对数据处理提出了极高的要求,需要更大的内存去存储更多的数据,不得不承认,高性能的存储能让AI技术发挥出*威力。但其实AI对存储也很重要,AI 时刻推动着存储的发展,究其原因绕不开存内计算(PIM :Processing in-memory)。

存内计算是一项打破传统冯诺依曼架构的新型运算架构,通过将存储和计算有机结合,直接利用存储单元进行计算,极大地消除了数据搬移带来的开销,解决了传统芯片在运行人工智能算法上的“存储墙”与“功耗墙”问题,可以数十倍甚至百倍地提高人工智能运算效率,降低成本。

虽然存内计算的基本概念早在上个世纪七十年代就已经被提出,但直到近些年才逐渐成为人们关注的焦点,原因在于,算力和运算数据量的激增导致存储墙问题愈发凸显,想要进一步提高算力,只有解决存储墙问题,而在各种解决方案中存内计算是最直接的一种方式,可以实现高能效、低功耗、低成本。

早在2019年,美光首席执行官 Sanjay Mehrotra 就指出,曾经的计算架构并不适合未来的发展趋势,从长远来看认为计算*在内存中完成。当时美光另一位技术高管也坚信计算和内存的融合对于提高性能效率和降低延迟是必要的,并愿意为此付出努力。不少业内人士认为,未来存储器可能不仅仅是存储设备,还可能是加速器,或者还会具备其他的功能,例如更好的ECC等。

那么,面对数据量激增的未来,如何应对内存带宽挑战,实现更优质的 PIM来减轻各种 AI 驱动所面对的诸如HPC、培训和推理等工作负载?AI就是一个很好的选择,随着技术的演进,越来越多的存储厂商开始加入AI战…

卡位AI,投资先行

如何最快获得一项新技术,投资/收购就是极为常见的一种方式,存储厂商开启AI投资热潮大约是在2018年前后,这一年也是人工智能的狂欢年,Google Duplex代替人类自动接打电话、欧盟正式发布的人工智能道德准则草案、OpenAI的5v5 DOTA AI“Open AI Five”再次完胜人类、全球*个“AI合成主播”正式上岗…种种一切似乎让人们意识到,只在小说中存在的AI时代真的要来了。

2018年6月,存储龙头三星公布了一项专注于 AI 科技和初创公司的新基金“Samsung NEXT Q Fund ”,将为那些解决AI问题以及使用AI解决计算机科学问题的初创公司提供种子轮和 A 轮融资支持,公告中特别提到,包括的领域涉及模拟学习、场景理解,问题学习方案和人机交互。

到了2018年8月,三星集团宣布,未来三年将在AI、汽车零部件等领域投资逾220亿美元,其中大部分投资由三星电子承担;2021年8月,三星再次公布未来三年会投资240万亿韩元(约合2055亿美元)到生物制药、人工智能、半导体、机器人等领域。从2018年的220亿美元,到2021年的2055亿美元,十倍的增长,虽然AI并不是三星电子加大投资的惟一领域,但显然已经是被锁定的新成长领域。

三星2018年投资计划重点 图源:路透

在2018年三星宣布成立新基金后不久,美光也宣布通过美光创投投入一亿美元在人工智能及机器学习新创公司,当时消息显示,投资新创不仅有助于加速人工智能的发展,还能间接带动对于DRAM与NAND内存与3D Xpoint等次世代内存的需求。

或许是投资已经没办法满足需求,又或许是美光进一步认识到了存内计算的重要性,到了2019年,美光科技直接收购了人工智能硬件和软件初创公司Fwdnxt,这在当时的行业内掀起了不小的波澜。美光认为,Fwdnxt的技术与美光的存储芯片结合使用时,能够使美光具备探索数据分析所需的深度学习AI解决方案的能力,尤其是物联网和边缘计算。

美光方面还表示,收购Fwdnxt不仅不会与英特尔、英伟达等有更多的竞争,相反反而会有更多的合作。在美光看来,没有人可以在数据中心领域与他们竞争,存储厂商想要分得一杯羹,为英特尔等提供更多帮助,那么在边缘计算方面进行研究,将会是美光获得*效率和规模经济的地方。

数据中心是互联网、云计算和人工智能等领域的通用支撑技术,中国信通院《数据中心白皮书2022》报告显示,2021年全球数据中心市场规模超过679亿美元,预计2022年市场收入将达到746亿美元。而存储和AI都是数据中心不可缺少的重要部分,一方面任何数据中心的数据最终都要放置到存储设备上。另一方面,AI能够帮助数据中心提高能源效率,进而节省成本,还能帮助优化运维,使用预测分析来帮助数据中心分配工作负载。那么,当数据中心的“左膀右臂”结合在一起,势必会带来奇效,这或许也是美光收购Fwdnxt的一部分考量。

而在2019年,SK海力士也加入了这场AI投资战,甚至攻势十分凶猛。2019年年初,SK海力士投资了地平线;2020年9月,宣布投资Gauss Labs公司,旨在通过工业人工智能(AI)解决方案引领半导体制造业创新;2022年1月,SK 海力士又同SK Telecom 以及 SK Square一起宣布,成立联合发展协会,首先将砸 800 亿韩元,在美国设立 AI 半导体公司 SAPEON,SK 海力士持有25%的股份,这对于SK 海力士来说,在 NAND 闪存以及AI领域的事业也会更进一步扩张。

“钞能力”下的技术成果

从投资方面来看,存储大厂对AI可谓是下足了“血本”,重金之下,厂商们的成果也是斐然,接连展示新技术。

三星电子在2021年2月率先研发出结合内存芯片和AI处理器的高带宽内存 HBM-PIM(也被称为 Aquabolt-XL),以强化数据中心、高性能计算(HPC)系统和支持 AI 的移动应用程序中的大规模处理。据了解,HBM-PIM 通过将经过DRAM优化的 AI 引擎置于每个存储子单元内,将处理能力直接引入到数据存储位置,从而实现并行处理并尽可能减少数据移动。数据显示,当应用于三星现有的 HBM2 Aquabolt 解决方案时,新架构能够提供超过两倍的系统性能,能源消耗也大幅降低。

三星电子DRAM产品和技术高级副总裁Nam Sung Kim表示,随着技术标准化发展,该技术应用将会进一步扩大,扩展至用于下一代超级计算机和AI应用的HBM3,甚至用于设备上AI的移动存储器,以及用于数据中心的存储器模块。最新消息显示,三星已经完成了运行其最新内存解决方案内存中高带宽内存处理 (HBM-PIM) 所需的软件标准化,计划在本月推出该解决方案。

SK海力士则在今年2月宣布,将与人工智能芯片公司 SAPEON合作,推出一款将 GDDR6-AiM 与 AI 芯片相结合的新产品。SAPEON即上述提到的SK海力士与SK Telecom 以及 SK Square在美国成立的AI芯片公司。GDDR6-AiM则是SK海力士在今年2月宣布的采用下一代存储芯片PIM技术开发出的样品,为 GDDR6内存芯片增加了计算功能,以 16Gbps 的速度处理数据。SK海力士声称,GDDR6-AiM 与 CPU 和 GPU 的组合,不是典型的 DRAM 芯片,可以将计算速度提高 16 倍,适用于机器学习、高性能计算和大数据计算与存储。

美光则是在收购FWDNX之后,推出一组用于深度学习应用的、功能强大的新型高性能硬件和软件工具,该综合性人工智能开发平台集成了计算、内存、工具和软件,可为探索针对人工智能工作负载优化的创新内存提供重要基石。FWDNXT是一种架构,专为打造快速上市时间的边缘AI解决方案而设计,通过非常易于使用的软件架构搭配广泛的模型支持与运用灵活度。据悉,美光深度学习加速器(DLA)技术支持广泛的机器学习框架和神经网络,能够通过易于使用的接口快速处理海量数据,在FWDNXT人工智能推理引擎的支持下,能让内存和计算能够更紧密地融合,从而实现更高的性能和更低的功耗。

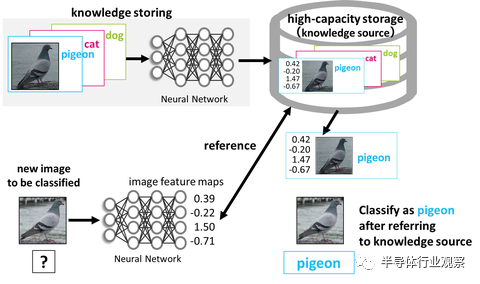

此外,不同于上述三家存储大厂,铠侠则是发力SSD和AI技术的结合,专注于研发以内存为中心的AI技术。近日,铠侠开发了一种基于Memory-Centric AI的图像分类系统,Memory-Centric AI是一项利用大容量存储器的人工智能技术,该系统使用神经网络对图像进行分类,未来铠侠会将Memory-Centric AI从图像分类扩展到其他领域,并促进采用大容量存储的人工智能技术的研究和开发。

利用高容量存储的图像分类 图源:businesswire

铠侠方面指出,传统AI技术是使用大量数据来训练模型,而以内存为中心的AI则是基于其积累的知识,通过搜索和参考这些知识来执行任务,因此它积累的新知识和记忆越多,人工智能就越成熟,更重要的是,这项技术可以让人工智能可以无限期地成长,同时也能减少所需的大量计算并减少功耗。

而这项技术的关键之处就是积累的数据存储在哪里,这就是闪存的用武之地,能够在几乎不消耗电力的情况下存储信息,但这也对闪存的速度提出了挑战,速度太慢会影响人工智能做出决定。随着访问速度的提高,硬件和人工智能技术也在不断发展,铠侠认为如今是提出以内存为中心的AI的恰当时候。

写在最后

AI从概念被提出来开始就似乎是一个“万金油”般的存在,5G需要AI、元宇宙需要AI、自动驾驶需要AI,甚至于连EDA都需要AI。如今,AI又已经“渗入”存储芯片领域,各大存储厂商为此展现出“十八般武艺”,但未来谁能成为拔得头筹者,我们拭目以待。