这一周来,OpenAI 不断巩固并扩展自己的朋友圈,先是与微软开启下一阶段的合作,现在又与全球*的云服务商亚马逊云科技(AWS)展开合作。

就在今天,OpenAI 与 AWS 官宣建立多年的战略合作伙伴关系。OpenAI 将立即并持续获得 AWS 世界级的基础设施支持,以运行其先进的 AI 工作负载。 AWS 将向 OpenAI 提供配备数十万颗芯片的 Amazon EC2 UltraServers(计算服务器),并具备将计算规模扩展至数千万个 CPU 的能力,以支持其先进的生成式 AI 任务。

双方合作的总额达到 380 亿美元,OpenAI 将快速扩大算力规模,同时利用 AWS 在价格、性能、可扩展性和安全性方面的优势。这也是史上*云服务交易之一。

OpenAI CEO 奥特曼和 Amazon CEO 安迪・贾西对双方的合作都表示了期许。

完整公告如下:

今天,AWS 与 OpenAI 宣布达成一项为期多年的战略合作伙伴关系,OpenAI 将获得 AWS 的世界级基础设施,用于运行和扩展其核心 AI 工作负载。

根据这项价值 380 亿美元的新协议(未来七年将持续扩大),OpenAI 将使用 AWS 计算资源,其中包括数十万块*进的 NVIDIA GPU,并具备扩展至数千万个 CPU 的能力,以快速扩展自主式智能体等 AI 工作负载。

AWS 在大规模 AI 基础设施的安全、可靠和高效运行方面拥有丰富经验,其集群规模已超过 50 万颗芯片。AWS 在云基础设施方面的*地位,并结合 OpenAI 在生成式 AI 领域的开创性进展,将帮助数以百万计的用户继续从 ChatGPT 中获益。

AI 技术的快速进步带来了前所未有的算力需求。随着前沿模型开发者不断推动模型智能达到新高度,他们越来越多地选择 AWS,以获得*的性能、规模和安全性。OpenAI 将立即开始使用 AWS 的计算资源,目标是在 2026 年底前部署全部算力,并在 2027 年及以后进一步扩展。

AWS 为 OpenAI 打造的基础设施采用复杂的架构设计,专为实现*化 AI 处理效率和性能而优化。通过 Amazon EC2 UltraServers 在同一网络上集群连接 NVIDIA 的 GB200 和 GB300 GPU,可实现低延迟的互联性能,使 OpenAI 能够高效地以*性能运行 AI 工作负载。这些集群被设计用于支持多种任务,从 ChatGPT 的推理服务到下一代模型的训练,并具备灵活的可扩展性,以适应 OpenAI 不断发展的需求。

奥特曼表示,「要扩展前沿 AI,就需要海量且可靠的计算能力。我们与 AWS 的合作强化了广泛的计算生态系统,这将驱动下一个 AI 时代的到来,并让先进的人工智能惠及所有人。

AWS CEO 马特・加尔曼表示,「AWS 的*基础设施将成为 OpenAI 实现 AI 雄心的支柱,我们优化计算资源的广度与即时可用性,充分体现了 AWS 为何能独特地支持 OpenAI 庞大的 AI 工作负载。

这项消息也延续了双方此前在全球范围内推动尖端 AI 技术普及的合作。今年早些时候,OpenAI 的开源权重基础模型已在 Amazon Bedrock 上提供,使数百万 AWS 客户多了新的模型选择。OpenAI 迅速成为 Amazon Bedrock 上*的公共模型提供方之一。

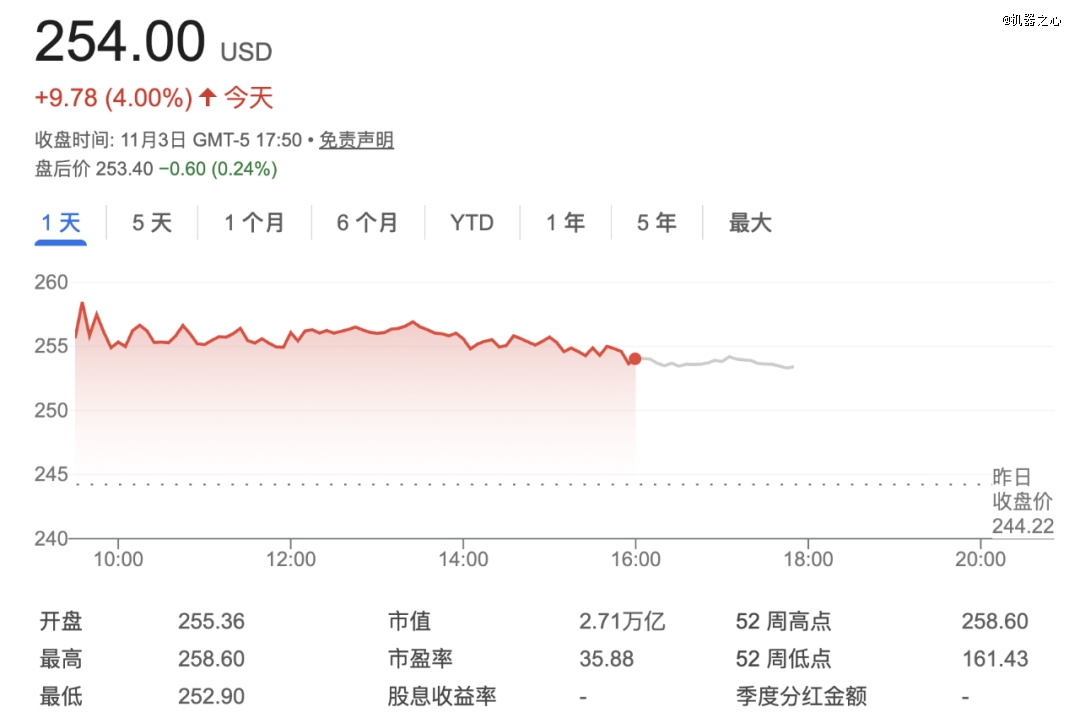

受此消息的提振,美股亚马逊截至收盘大涨 4%。

参考链接:

https://www.theverge.com/news/812443/openai-amazon-38-billion-cloud-computing-ai

https://openai.com/index/aws-and-openai-partnership/