谁也不曾想到,大模型产业的首次“集体会战”,居然围绕价格展开。

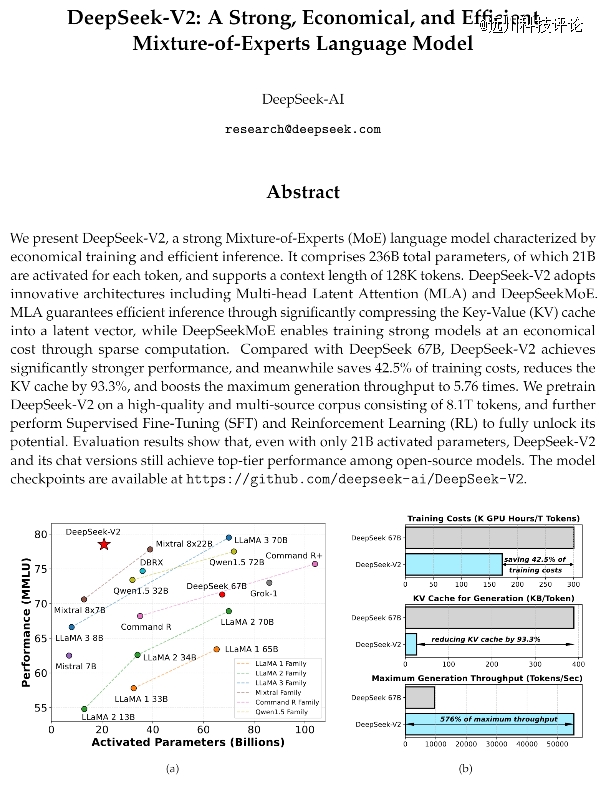

5月6日,私募巨头幻方旗下的深度求索,打响了降价*枪。深度求索发布的模型DeepSeek-V2(32k),在数学、编程、中英文等能力上已逼近GPT-4;然而,DeepSeek-V2的使用价格仅约为GPT-4o的1/35。

DeepSeek-V2的输入与输出价格分别为1元/百万tokens和2元/百万tokens,远低于市场价。

比拼多多砍一刀还便宜的价格,惊动了不少美国专家。知名分析师Dylan Patel读完DeepSeek-V2的论文后,激动地表示,“这可能是今年*的一篇。[1]”

DeepSeek-V2的论文

一周后,“卷王”字节跳动又添一把火。

豆包通用模型Pro-32k的输入价格,被一刀砍到了更低的0.8元/百万tokens。火山引擎总裁谭待表示,“豆包比行业价格低了99.3%,大模型从此以厘计价。”

眼看友商如此不讲武德,其他科技公司再也坐不住了。

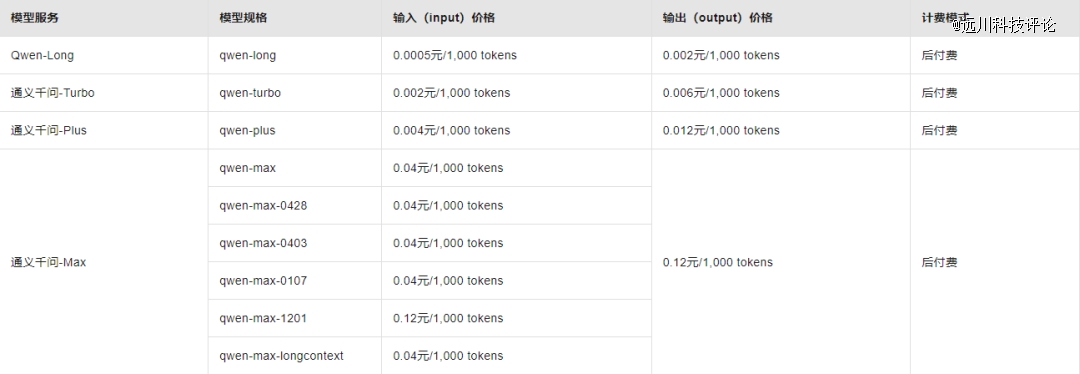

阿里率先回击,一狠心,大举下调了所有模型的价格。

几个小时后,百度干脆冲向竞价终点:宣布两款轻量级模型全面免费。紧接着,科大讯飞星火Lite API、腾讯混元大模型lite 256k也相继宣布免费。

如此盛况,很难不让人梦回那段滴滴大战快的、ofo摩拜互扯头发的激情岁月。

然而,围绕大模型的价格战,远不如网约车、共享单车那般直观,各种专业名词让人摸不着头脑。所以,这些大模型公司,到底在热闹些什么?

价格战的B面

想要理解这点,首先得知晓大模型的商业模式。以阿里云为例,它所提供的大模型服务,共有3种[2]:

(1)基础服务:模型推理。

模型推理,指的是根据输入的信息内容,给出回答的过程。换句话说,推理就是“实际使用”模型的过程。

阿里云预置了多个性能不同的“标准版模型”,供用户推理。该服务的计费方式很简单,即“以量计价”:以消耗的token数量为单位,用得越多,费用越高。并且性能越好的模型,收费越贵。

token是大模型用来衡量文本长度的一种计数单位,可以简单理解为“字数”。3本篇幅为75万字的《三国演义》,大约需要125万个token。

(2)进阶服务:模型微调。

如果觉得“标准版模型”不好用,阿里云还提供了“定制研发”服务,即模型微调。具体收费,则取决于“定制研发”消耗的计算资源与开发周期。

(3)超进阶服务:模型部署。

当用户需要长期使用大模型时,*的方式是将它部署到独占实例中。

独占实例,指的是直接承包一个或多个物理服务器的全部资源。翻译成人话就是,不再只是租一个商铺,而是将整个商业广场都租下来。

这么做的好处在于,没有别的商户和你抢计算资源,响应速度更快。

其收费模式,也是以量计价,但有两种形式:阿里是直接按照“商业广场”消耗的计算资源计费;除此之外,百度还支持按照模型推理的token数量计费。

这3种收费模式,面向的是企业与个人开发者,代表了大模型开发由浅入深的过程。而各大科技公司疯狂砍价的,其实是上文提到的“基础服务”,即“标准版模型”的推理费用。

推理费用的具体定价,又分成了“输入”和“输出”两部分。

简单来说,输入就是用户提问的内容,而输出则是大模型的回答。科技公司往往会根据输入和输出的token数量(字数),进行两次计费。

这种复杂又细微的差异,很容易成为科技公司的套路。

例如字节跳动的“0.8元/百万tokens”“比行业价格低99.3%”,其实只是输入价格。豆包通用模型Pro-32k的输出价格仍是2元/百万tokens,与DeepSeek-V2等同行持平。

由此可见,别看大模型价格战打得火热,背后实则另有洞天。

降价的千层套路

可以发现,本轮价格战最为活跃的,基本上都是云计算公司,代表厂商是BAT和字节跳动。

它们之所以敢如此降价,还是因为能从别的地方弥补损失,羊毛出在羊身上。

正如前文提到,降价乃至免费的,其实只是基础服务。

毫无疑问,这可以帮助中小开发者以更低的成本构建应用。然而,当开发者或者企业,需要更贴合自身业务,深入使用大模型时,往往绕不开进阶的模型微调和模型部署——这两项服务,可不是本次价格战的主角。

例如百度宣布免费的ERNIE-Speed-8K,如果实际部署,收费就变成了5元/百万tokens[3]。

与此同时,各家降价最狠的,其实都是轻量级的预置模型;相比之下,性能更强悍的“超大杯”模型,实际降价幅度没有那么夸张。

例如阿里的Qwen-Max,实际与字节跳动的豆包通用模型Pro-32k一样,只是降低了输入的价格;而隔壁的百度,压根没提超大杯模型。

云计算厂商的价格战,更像是用“免费游戏”的形式吸引更多玩家加入;但若想继续“升级变强”,该氪金还得氪金。

当然,云计算厂商并非*的参与者。

以深度求索与智谱AI为代表的明星初创公司,之所以也敢跟进内卷,很大程度上是因为有充足的弹药,尤其是算力资源。

早在大模型尚未爆发的2020年,背靠私募巨头幻方的深度求索,就投资了上亿元筹建AI超级计算机。

目前,幻方是除BAT、商汤、字节跳动外,第六家拥有1万张以上英伟达A100 GPU储备的中国公司[4]。

而智谱AI则背靠阿里和腾讯,是估值过百亿的AI独角兽公司。

2020年时,智谱AI也碰巧囤积了不少GPU资源。其CEO张鹏曾在接受《中国企业家》采访时提到:

当时,他认识的一家云计算厂商,有一批GPU积灰了。这批GPU原本是供应给游戏公司的,但阴差阳错之下,对方又不买了。张鹏知道这个消息后,顺势接盘了这批计算资源[5]。

现金流、算力资源都充足的情况下,即便烧钱换市场,这些初创公司也能扛得住。

那么问题来了:当年移动互联网补贴换市场,尚可以简单粗暴地归因为“技术门槛低”;主打一手高科技的大模型,怎么也没走出价格战的怪圈?

必经之路

大模型智能化带给世人的震撼,往往让人忽视它的本质,其实是一种基础设施。

去年,知名计算机科学家吴恩达曾在公开演讲中提到:

AI其实是一系列工具的集合。这些工具包括了监督学习、非监督学习、强化学习,以及现在的生成式人工智能。所有这些都是通用技术,意味着它与电力和互联网等其他通用技术,并没有什么区别[6]。

电力与互联网,并没法直接创造价值;真正改变世界的,其实电灯、电脑、电商、电子游戏。

然而,应用的爆发其实有一个前提:即基础设施足够便宜。此前,大模型应用没能快速铺开的一个主要困境,正是使用成本过高。

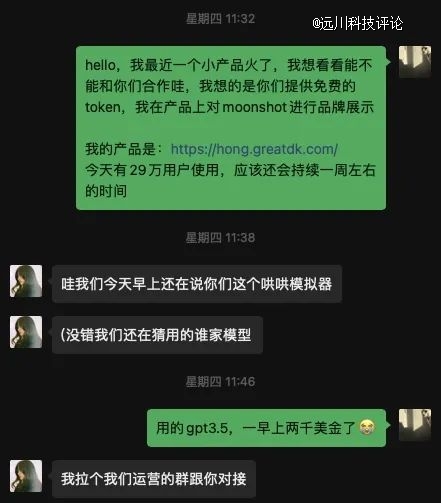

哄哄模拟器就是一个典型的案例。

今年年初,一位名叫王登科的独立开发者,开发了一款模拟“生气女朋友”形象的AI应用。该应用的玩法很简单,用户必须斗智斗勇哄好对话窗口里的AI女友。

因为交互简单和立意颇有情趣,哄哄模拟器上线*天就吸引了60多万用户。

突然的爆红,却让王登科哭笑不得。哄哄模拟器使用了预置的GPT-3.5模型,运营一早上就花了他2000多美金的推理费用。

这就相当于,开发了个App,还没想到咋赚钱,先交了1万块钱电费。

纵观历史可以发现,当年移动互联网的大规模普及,也是建立在基础设施降本之上的。

2014年的一份调查报告显示,当时由于流量费用高昂,手机用户每天使用流量不会超过3小时。且不使用移动网络时,很多用户会选择将其关闭,以防止手机应用在后台消耗流量[7]。

彼时,大多数用户,都曾做过“一觉醒来房子归中国移动”的噩梦。

2013年的时候,快手就明确了“短视频社区”的定位,但增长相对缓慢。这背后,很难说没有大环境的原因。

事实上,直到电信运营商开始大搞“降费提速”,短视频行业才真正开始爆发。

2019年,手机上网流量资费较2014年时已下降了超90%[8]。至此,手机淘宝、微信、抖音等才逐渐成为字面意义上的“国民应用”。

由此可见,降价其实是大模型产业发展的必经之路。

也许在这轮价格战中,云计算厂商与初创公司,各有各的小九九;但对开发者和普通用户来说,建议可以打得再狠一点。

参考资料

[1]OpenAI Is Doomed,SemiAnalysis

[2]阿里云大模型服务平台百炼

[3]千帆大模型平台

[4]量化巨头发布*代大模型:免费商用,完全开源,澎湃新闻

[5]智谱AI CEO张鹏:中国大模型创业者,不再追随OpenAI,中国企业家

[6]Andrew Ng: Opportunities in AI - 2023,Stanford Online

[7]2014年中国手机流量使用报告:近四成用户流量不够用,中国新闻网

[8]工业和信息化部组织召开“提速降费”用户面对面座谈会