随着大模型概念火热,算力成为各行各业关注的热门话题。英伟达显卡被抢爆,媒体关注“大模型时代到来,算力够不够”,行业想要解决AIGC时代的算力瓶颈问题。然而,发展大模型,是否解决算力问题就够了?

1、算力是大模型的底座

大模型是在智能算力驱动下最为典型的重大创新。得益于模型泛化能力强、长尾数据的低依赖性、以及下游模型使用效率的提升,大模型被认为具备了“通用智能”的雏形,并成为业内探索实现普惠人工智能的重要途径之一。从算力的视角看,语言类、视觉类模型容量和相应的算力需求都在快速扩大,大模型发展的背后是庞大的算力支撑。作为算法的结晶,需要处理大量的数据。人工智能背后需要大量的硬件支撑,已经成了新时代的“重工业”产品。

算力决定了数据处理能力的强弱。算力芯片是算力的具体载体,高算力芯片能够提供超算算力、通用算力、智能算力和边缘算力。搭载率最高的GPU芯片多用于图形图像处理、复杂的数学计算等场景,可较好支持高度并行的工作负载,经常用于数据中心的模型训练,或用于边缘侧和端侧的推理工作负载。

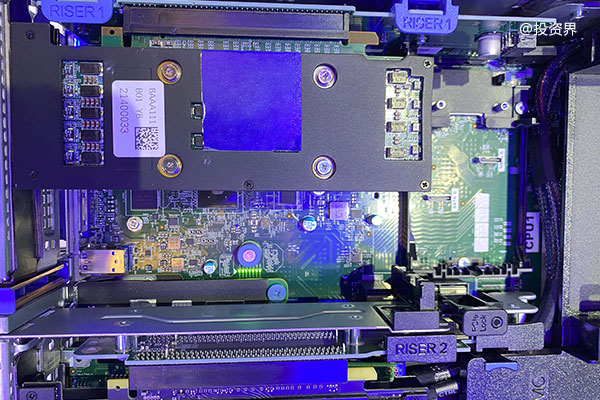

服务器是算力的基础设施之一。服务器的逻辑架构和普通计算机类似,但是由于需要提供高性能计算,因此在处理能力、稳定性、可靠性、安全性、可扩展性、可管理性等方面要求较高。人工智能服务器由于具备图形渲染和海量数据的并行运算等优势,能够快速准确地处理大量数据,市场价值逐渐凸显。

随着数据应用的搭载率较低的NPU芯片,设计逻辑则更为简单,常用于边侧和端侧的模型推理,并生成结果,在处理推理工作负载时,具有显著的能耗节约优势。根据IDC统计,2021年中国仍以GPU为主实现数据中心计算加速,市场占有率近90%,ASIC、FPGA、NPU等非GPU芯片市场占有率超过10%。据IDC预计,到2025年人工智能芯片市场规模或将达726亿美元。

IDC数据显示,2021年全球人工智能服务器市场的同比增速超过全球整体人工智能市场的增速,是整体人工智能市场增长的推动力。IDC发布的《全球人工智能市场半年度追踪报告》显示,2021年全球人工智能服务器市场规模达156.3亿美元,约合人民币1,045亿元,这是全球年度人工智能服务器市场首次突破千亿元人民币,同比2020年增速达39.1%。

这样的背景下,国内算力芯片公司“快马扬鞭”。例如,龙芯中科计划明年下半年将完成兼顾显卡和算力加速功能的专用芯片流片;龙芯GPU的定位主要是为了与CPU形成自我配套,形成系统优势,降低系统成本。

2、国产存力需要重视

数据存力指的是以存储容量为核心,包含性能表现、安全可靠、绿色低碳在内的综合能力。

在国家数字经济大战略下,数据作为生产要素,已成为重要的资产。随着海量数据呈指数级增长,数据流动加速,存储作为承载数据的关键设施,其重要性更加凸显。作为数据大国,数据存储产业就需要跟上。大模型正在带动各地建设AI算力中心,但是产业主要关心的都是运算力。倪光南院士认为算力中心的计算能力由三个因素决定:存力、算力、运力。倪光南院士认为,用广义算力去定义一个算力中心,才更准确。如果去计算存算比的话,美国的算力中心存算比为1.11TB/GFlops,中国约为美国的37.8%。

我国数据存力发展总体水平与发达国家相比仍有一定差距。据罗兰公司测算,美国单位GDP存储容量高于我国,我国存储在经济发展中的支撑作用有待加强。据中国信通院统计,2021年我国存储总量容量已达800EB,出货量年均增长速度已达50%。

为了发展国产算力,在技术方面,需要加快部署下一代存储技术,推动存储核心技术底层研发和技术攻关,提升存储介质、安全设计、数据防护等关键技术水平,打造全球存储的创新高地。存储领域正在发生一场新的技术变革,即基于半导体技术的新型产品替代基于机械技术的传统产品,这一个正在加速进行的客观趋势。SSD可以实现用先进的压缩算法,把数据更好地压缩,可以去重,可以更好的加密解密,用新的文件系统等等。

在标准方面,应尽快研究建立存储的行业规范和标准,完善数据存储效率、数据保护、数据灾备、绿色低碳等数据存力关键标准体系。存储相关企业及研究机构进行标准和评估体系研究,鼓励行业龙头企业通过硬件开放、软件开源、使能生态伙伴等策略,给予合作伙伴尤其是创新型小微企业充分的发展空间,共同摸索形成存储行业标准;另一方面,推进数据存储产业国际交流与合作,加强与国际标准组织的合作,加速我国技术标准的国际化进程,积极参与数据存储国际规则和技术标准制定。

在人才培养方面,存力市场有必要进一步完善数据产业人才培养机制,建立多层次、多元化的人才培养系统,鼓励培养专业理论与行业知识兼备的复合型人才,鼓励地方政府引导企业完善人才激励机制,引进和留住高端存储专业人才,优化人才的地域和行业布局。存力产业,包括数据存储,数据管理技术。目前国内对存储的概念还停留在一个小的部件,没有把它上升到一个产业的高度。

有强大先进的数据存储产业作为支撑,才能有发展算力主动权。

3、国产运力,沉默的搬运工

如果说存力已经开始逐渐受到重视,那么国产运力相对来说可能还是一个“小透明”。但对于大模型训练来说,“运力”已经成为关键因素。英特尔公司高级副总裁兼网络与边缘事业部总经理Sachin Katti表示,在云端训练大模型,单个服务器已无法承载,对网络需求的高要求前所未有,“我们训练一个大模型就需要5万-20万台服务器,需要通过网络来把这些服务器连接起来然后进行训练,这个量是非常大的。”

数字世界的运力,指的是数据传输流转的能力,由带宽、时延、安全可靠等要素组成。面对强劲的算力需求,英伟达推出了云算力平台,企业可以租用算力,谷歌、微软AZURE等云算力平台会为其提供算力支持。而与租用的服务器的链接也会成为影响企业模型训练的因素。

各类智能化应用的普及,导致大量视频数据、科研数据需要流动、调度、分析处理,带来的网络压力和运力负担也越来越大。

中国移动通信研究院发布的《面向AI大模型的智算中心网络演进白皮书》测算,以1750亿参数规模的GPT-3模型训练为例,从理论估算模型分析,当动态时延从10us提升至1000us时,GPU有效计算时间占比将降低接近10%;当网络丢包率为千分之一时,GPU有效计算时间占比将下降13%;当网络丢包率达到1%时,GPU有效计算时间占比将低于5%。“如何降低计算通信时延、提升网络吞吐是AI大模型智算中心能够充分释放算力的核心问题。”

对于大模型来说,在训练大模型时,模型参数存储于加速器(如GPU显卡)的片外缓存中,随着训练进程对模型参数进行不断更新迭代。在训练过程中,不同加速器之间需要进行频繁且大量的数据交换,在数据交换完成之后,才能够去算下一步的训练结果。从这个角度来说,好“运”,才能好“算”。在这一点上,英特尔除了提供CPU、独立显卡等芯片,满足人工智能模型训练、推理对算力的要求外,也提供了针对网络的IPU(Infrastructure Processing Unit)产品。

从这一角度来看,在AI芯片赛道已经有巨头把控且新玩家层出不穷的情况下,布局运力系统或许是另一片蓝海。更重要的是,从宏观角度来看,运力是将算力和存力高效传输给终端用户,它在基础设施中起到非常重要的作用。以被熟知的“东数西算”工程为例,它还包含西数西算、南数南算、东数西存等,而实现这些规划的前提是要有强有力的运力做支撑。运力网络要让用户在调用成百上千公里以外的计算资源时的体验与调用隔壁工作站的资源没什么区别。对于一个城市的大数据中心,就需要实现城市乃至国家层面综合调度的能力。

在“三力”基础上打造智慧管控能力,实现高效调度,才有希望实现算力一体化服务。不久前,成都最新发布政策,指出将围绕“算力”“存力”“运力”等关键领域,大力发展芯片、服务器整机、液冷设备等高端硬件。显然,行业已经意识到,对于发展大模型,全面发展不能仅堆算力芯片。