自从生成式AI以势如破竹的速度席卷几乎每一个领域,AI挑战人类的担忧也越来越真实。

上次,马斯克就人工智能研究界和产业界的大佬们一起发布了一篇呼吁的公开信,呼吁全球所有实验室暂停比更强的AI模型研发,暂停时间至少为6个月。但结果被人扒出其实他为Twitter购买了1万个GPU用于推进一个全新的AI项目,极有可能正在开发自家的大语言模型。

但这一次,又一封呼吁人们要重视AI带来威胁的公开信又发出。比上一次更引人注目的是,目前生成式AI领域鼎立的三大巨头:OpenAI 、DeepMind(隶属于Google)、Anthropic都加入其中。

22字声明,350人签名

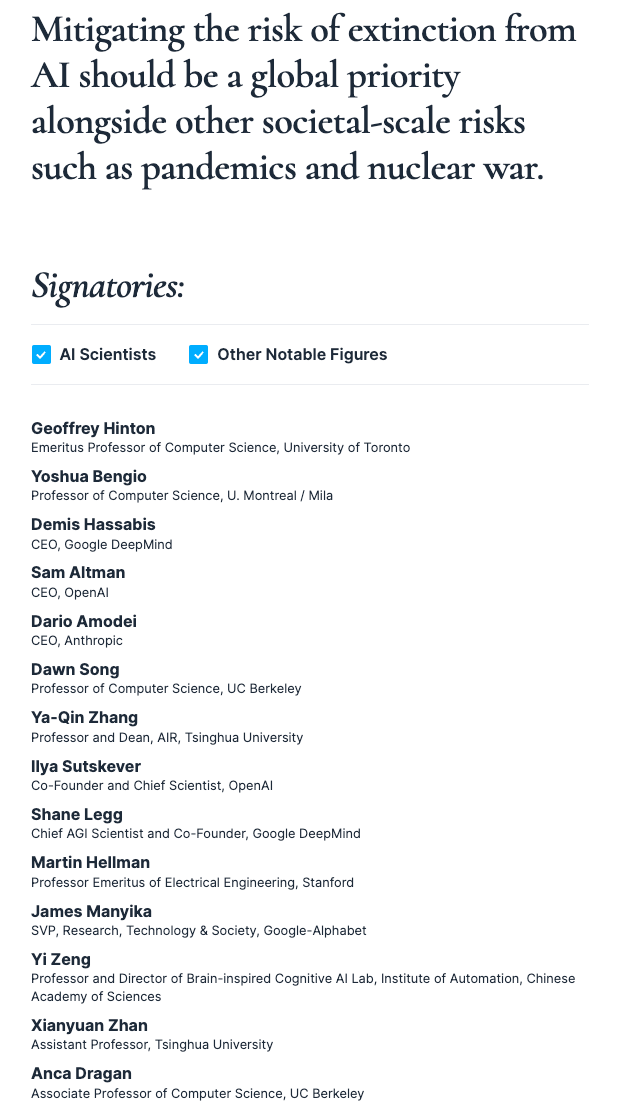

这份声明由总部位于旧金山的非营利组织AI安全中心发布,就他们认为AI对人类构成的生存威胁发出了新的警告。整份声明才22个字——对,你没看错,才22个字,全部内容如下:

减轻 AI 灭绝的风险,应该与管控流行病和核战争等其他社会级规模的风险一样,成为一项全球优先事项。

尽管AI威胁论并不新鲜,但如此直白地把它和“核战争”、“大流行病”等危害全体人类的危机因素列在一起公开作比较,还是属于首次。

声明的署名部分比声明的内容长得多。

除去OpenAI首席执行官Sam Altman、DeepMind首席执行官Demis Hassabis和Anthropic首席执行官Dario Amode以外,超过350名*AI研究人员、工程师和创业者也加入其中,包括曾经获得图灵奖的“AI三巨头”之二Geoffrey Hinton和 Yoshua Bengio,但另一位和他们一起获奖的、现任Facebook母公司Meta首席 AI 科学家的Yann LeCun尚未签名。

此外,名单里还出现了中国学者的身影,包括中国科学院的自动化研究所人工智能伦理与治理研究中心主任曾毅,清华大学副教授詹仙园等。

声明发布者AI安全中心的执行主任Hendrycks表示,这一份声明很简洁,特意没有提出任何减轻人工智能威胁的潜在方法,就是为了避免分歧。“我们不想推动包含30种潜在干预措施的庞大措施组合,”Hendrycks说。“当这种情况发生时,它会淡化信息。”