这是1968年科幻电影《2001:太空漫游》中的经典场景,人工智能HAL9000拒绝了人类的请求,由此展开了殊死搏斗。

如今也成为深度学习巨头、图灵奖得主Yoshua Bengio最新博文的封面:危害人类的AI是如何出现的。

近几个月来,强人工智能对话系统的兴起,引发了各种AI风险的讨论。

即便科学家们普遍认为,有必要对人工智能进行监管,但对于「AI系统是否会失控,进而对世界造成灾难性损害」存在深刻的分歧。

事实上,这些灾难会如何发生,存在诸多不确定性。于是Bengio团队做了一系列的正式定义Rogue AI、假设和主张,并讨论了发生条件、可能情况以及规避策略。

一时间引发热议,不少学界人士站出来推荐:

在不改变原意的基础上,量子位联合ChatGPT做了如下编译。

1、Rogue AI如何出现

定义1:一个潜在的Rogue AI,是一个自主的人工智能系统,其行为方式可能会对大部分人类造成灾难性伤害,可能会危及我们的社会,甚至我们的物种或生物圈 。

人类大脑是一种生物机器,我们在理解和展示人类智能多个方面的原理上取得很大进展,比如从实例中学习知识和熟练运用语言。虽然我也相信人们有能力设计出有用且安全的AI系统,但必须遵守具体指导方针,比如限制他们的机构。

然而最新进展表明,超级智能AI(全面比人类聪明)的建立离我们预期比以前更近,我们不清楚如何防止潜在的Rogue AI产生。

Rogue AI是目标驱动的。当前大模型几乎没有自主能力,但正如Auto-GPT那样可以转化。更深入了解Rogue AI的产生方式,需要在技术和政策方面的努力。

AI对齐问题(人类真实意图与人工智能的理解和行为不匹配)以及社会竞争压力将有利于更强大、更自主的AI系统的产生,不自觉间就增大了Rogue AI诞生的可能性。

假设1:人类水平的智力是有限的,因为大脑是生物机器。

假设2:一台具有人类水平学习能力的计算机,通常会因为额外的技术优势而超过人类的智力。

如果假设1正确,那么会存在超级智能AI系统执行人类无法完成的任务(或者能力和速度不在一个水平上),至少有以下方面的原因:

一台计算机的AI系统可以在任意数量计算机上进行自我复制、获取经验并聚合。

AI已经能相当快速阅读整个互联网的内容。

此外,人类大脑还具有进化赋予的能力,当前一些相关的AI研究也正在进行。至于进化需要高能量消耗,这点在AI上已经实现。例如训练目前*进的大模型的一万个GPU集群。

定义2:一个自主的、目标导向的智能实体会设定并努力实现自己的目标(可能作为人类设定目标的子目标),并相应地采取行动。

需要注意的是,自主性可能产生于人类设定的目标和奖励。当主要目标是生存和繁殖,那么它将是完全自主的,这是最危险的情况。

如果这些目标不严格包括人类和生物圈的福祉,即不足以与人类的权利和价值观保持一致,那么这样的系统就有可能成为潜在的Rogue AI。

下面这些情况都将可能导致Rogue AI的出现:

不怀好意的人类。

构建AI Agent的意外后果。除非AI对齐研究取得进展,否则没有强有力的安全保障。

企业失控。企业可以被视作特殊的人工智能,其构建模块是企业中的员工,他们大部分时间意识不到企业整体行为的后果。

人类对创造类人实体的迷恋。正如科幻小说/电影中看到的, 这些实体具有情感、人类外貌甚至意识。

我认为我们应该远离那些外貌和行为都很像人类的AI系统,因为他们可能会变成Rogue AI。

AI Agents之间进化压力的意外结果。不同人类和组织争相设计更强大的AI系统,成千上万的研究员给予AI指令,这种过程可能会激发AI学习更快。

以上分析和AI安全研究能帮助我们设计政策、降低潜在风险。

比如前阵子”的呼吁,就是个很好的开端。这需要国家监督和国际协议,条约需要各国来共同达成。这类似于上世纪50年代关于禁止核武器条约。

为了保护公众、社会和人类免受灾难性后果,减缓高风险的人工智能研究和应用进展是值得的。

当然这也不会阻止一些有益研究,比如帮助科学家更好地理解疾病和气候变化的人工智能系统。

不过资本主义竞争本质将可能导致Rogue AI行为,AI经济学家将会帮助我们设计出不依赖竞争、更关注利润*化的经济体系,并提供足够的激励和惩罚机制。

Rogue AI的风险是可怕的,但它也可能成为重新设计我们的社会,使之朝着更广泛福祉的方向发展,比如解决医疗、教育资源不平等问题。

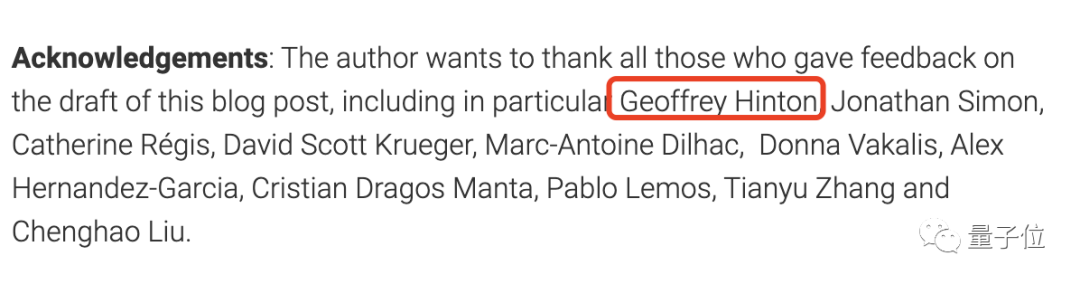

2、首先感谢Hinton

值得一提的是,在这篇博文的最后,Bengio还特意感谢了Hinton,可是放在了*位哦~

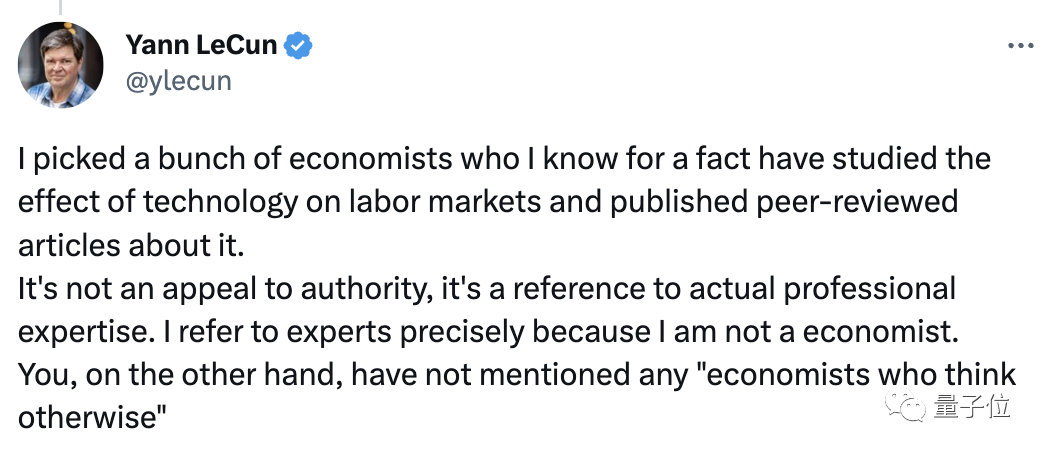

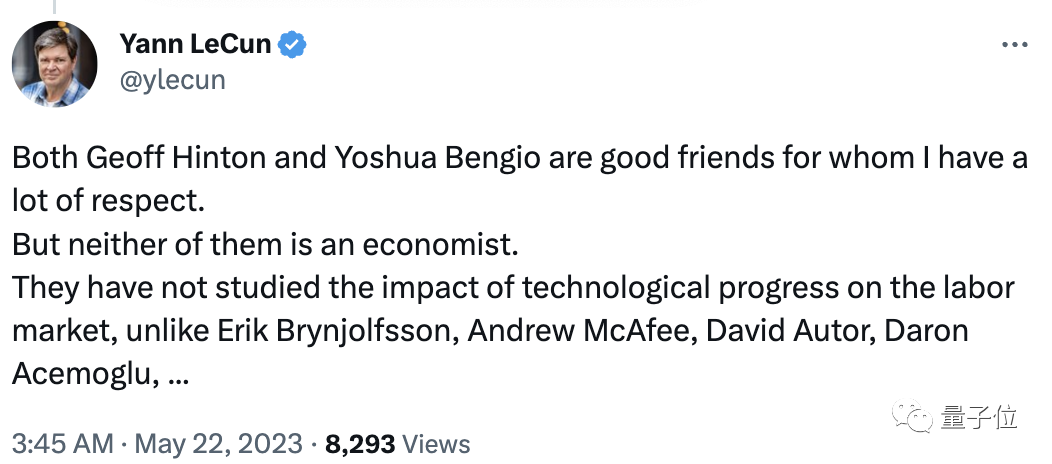

而就在此博文发布之际,LeCun也浅评价了他俩:

他们都不是经济学家,没有研究技术进步对劳动力市场的影响。

嗯,而他自己却经常与经济学家交流。(手动狗头)