在新一代GPT问世后,微软旋即推出了Microsoft 365 Copilot,新的办公软件由GPT-4驱动,在减少大量用户操作下,协助生成文档、电子邮件、演示文稿和更多内容。

处理效率之高,愈发让人惊呼,生产力和人机交互的新一轮革命不再只是想象。

新技术的颠覆效果,往往看它能否展现出更低成本、更高产出、更省时间的产品力。

为GPT提供算力的CPU服从摩尔定律,即每隔18-24个月(更省时间),原来的晶圆上封装的晶体管数量将会翻倍(更低成本),芯片的性能也会随之翻倍(更高产出)。

能够实现以上三角的优化解决方案,最终会推动飞轮旋转,实现强大的规模效应。而Open AI与微软的合作,似乎在朝着这个方向努力。

01、GPT-4让我们离AGI又近了一步

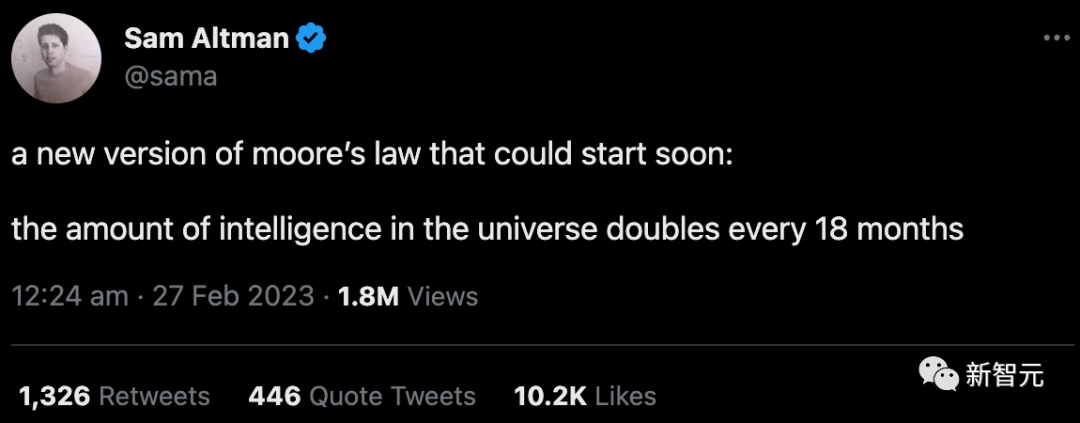

ChatGPT风靡全球之后,OpenAI的创始人Sam Altman曾表示,一个全新的摩尔定律即将出现,宇宙中的智能数量每18个月翻一番。

来源:推特

AI的复杂性会随着市场边界的扩大而进一步加深,具有涌现出新特性的潜质。

模型的底层逻辑是算力、数据、算法三位一体的结合,但复杂程度与数据规模相匹配。

随着参数量的增长,大模型的能力比起小模型要更加泛化。如果小模型的目标是做一个行业专家,那么大模型的定位则是要成为一个通才。

AGI(通用人工智能)被设计的目的,是让机器模仿并逐渐超越人类,实现与人类相近的能力,计算、推理、思考、创造,但是会更快、更高效。

学会吸纳更多的参数,是大模型复杂度提升的基础条件,数据就是AI 的血液。

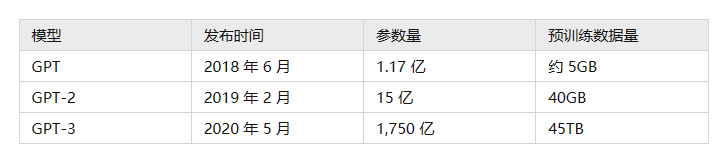

*代GPT的训练参数只有1.17亿参数,模型引入了Transformer架构,在处理文本的时候,学会利用上下文信息来预测下一个单词。

在处理不同的任务时,仅需要对预训练形成的网络结构进行微调,就能取得比传统NLP模型更好的泛化效果,也加快了模型处理数据的效率。

GPT2.0阶段,模型学会了多任务处理。开发者再次测试了容量对于性能提升的帮助,不再需要标注,而是让模型根据给定的指令去理解任务。

这个阶段的训练表明,随着模型容量和数据增大,不需要给模型提供样例,它也能够很好地理解并且完成任务。

基于这层理解,到了GPT-3,开发者也就有了更大的底气实现参数规模的跃迁,在海量语言模型参数集中,少数样例设置下,GPT的准确性继续得到提升。

语言模型参数增加,GTP在NLP任务上表现提升

来源:AI21 Labs

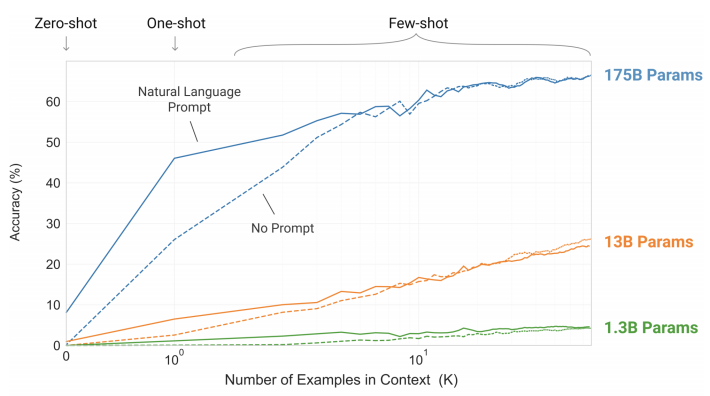

到了第四代,模型之间的代际差异随着任务复杂度的提高更加明显,这是GPT-4能做到的事情:

考试成绩取得比老版本更好的表现,意味着语言理解、推理能力持续进步;

语言风格更加灵活,GPT-4向我们展示了她能够当好一个耐心的数学老师;

支持文字和图像的混合输入,并且能够精准地描述图片上的内容,理解任务要求并生成代码。

来源:Open AI

国内百度16日发布了对标chatGPT的产品“文心一言”,也已经能够支持多模态的转换,文字可以直接在对话中生成图片和视频。

随着多模态的实现,基于自然语言模型的GPT未来有希望率先向AGI靠拢:

大幅降低内容生成的门槛;

学习成为各个领域的专家,作为企业业务增长、科研进度加快的重要抓手;

革新人机交互的方式

OpenAI开放GPT 的初衷不仅在于找到*的落地应用,而且在复杂的人类信息流里得到反馈,扩大其能力的边界。代际之间,GPT快速进步的能力超乎想象。

基于AGI最终很可能会实现的设想,AI的安全也将逐渐上升为一个全人类的重要议题。

OpenAI因此会在正式版本发布之前花费数月的时间进行风险评估,不过最终,无论进行多严格的审查,人类的未来始终该由全人类来共同决定。

02、微软的iPhone时刻

杀手级应用的诞生,对加速生产力变革具有重要的转折作用。

19世纪末的蒸汽机靠烧煤提供动力,但操作和燃料需要耗散大量人工和效率。后来西门子率先发明了电动机车,只消铺一条电线,不过当时电费比煤费还要贵,需要频繁充电。

直到福特T型车横空出世,流水线生产让汽车制造成本大幅降低。随之重量更轻、体积更小、操作更灵活的内燃机汽车开始走进千家万户,逐渐替代了蒸汽机和电动机。在这之后我们又有了飞机和火箭。

AI的应用,让人和计算机交互的方式产生了剧变。微软CEO曾经表示,Copilot的自然语言交互将是下一轮人机交互方式变革的雏形。

从图像界面的PC,到iPhone多点触控的智能机,每一次人机交互方式的变革孕育着全新的下游应用生态。

过去的AI就只是大模型,把几十台服务器放在一起训练,没有落到实地的应用。OpenAI与微软的合作,实现了两件事情。

一是跑通了商业模式,GPT的训练和日常运营背靠微软Azure的算力支持,微软云服务Azure的市场份额仅次于AWS,是谷歌的两倍。

巨额算力和AI大模型的结合,允许OpenAI进一步推出订阅式服务,形成了MaaS(Model as a Service)。

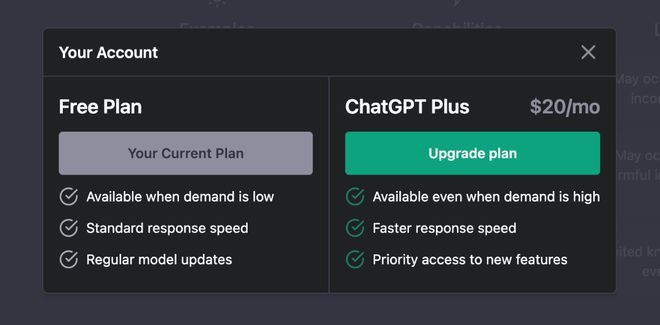

Open AI 有两种订阅模式,一种to B,给企业客户和开发者提供ChatGPT API,一千个token输入按0.002美元算,另一种to C,给普通用户开放最新功能,每个月收20美元。

用户的快速增长摊平了训练和推理所需的算力成本。GPT经过用户反馈的自主增强学习后,能力有了更快的提升,形成良好的正反馈机制,跟平台粘性越强,获客成本就越低是一个道理。

来源:ChatGPT

二是在微软的加持下,GPT和Bing、Gibhub以及Office等多个在线工具深度绑定。你有技术,我有产品,两家在商业化上拥有*的协同效应,率先完善了云计算+AI大模型+应用工具开发的生态。

微软和谷歌两家巨头对于推进AI应用有着截然不同的态度。

交互界面的改变对两家来说都如同革自己产品的命。不同之处在于,微软的产品矩阵更快速地适应了进化。

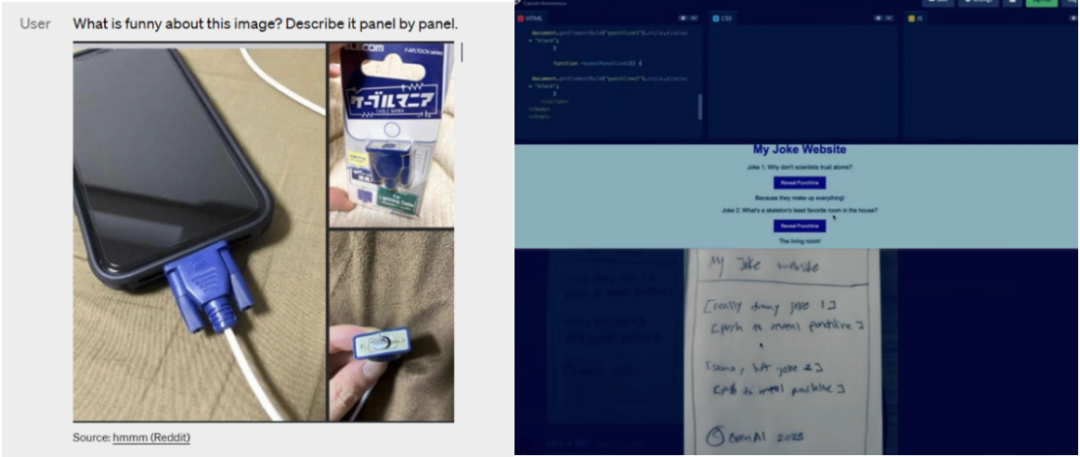

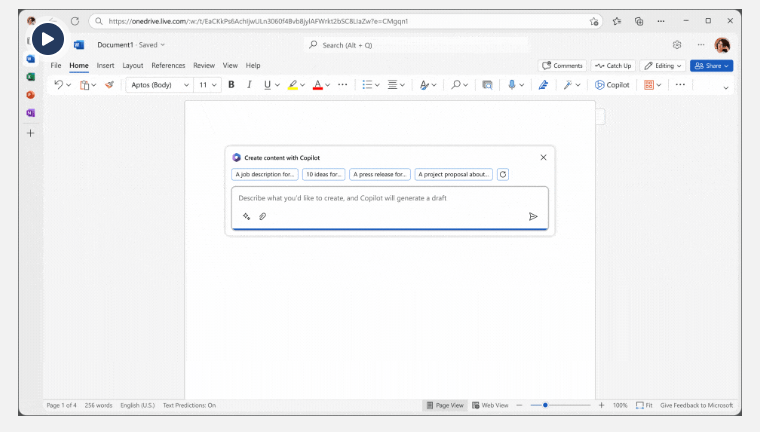

GPT-4推出不久后,微软即正式为365应用服务提供GPT-4驱动Copilot,对于用户而言就像一个办公助手,附着在侧边栏。用户可以调用它来生成文档,根据文本创建PPT,或者分析Excel数据。

来源:Microsoft 365 Copilot

有了GPT的赋能,对于微软产品本身便是如虎添翼,这块业务,“Productivity and Business Process”去年下半年的收入达到了330亿美元。全面铺开后,增长有着更大的想象空间。

未来人们转向AI聊天界面来搜索信息,必然会给搜索引擎的广告业务带来巨大冲击。而谷歌的广告收入占了营收的80%左右,其中占大头的还是搜索广告。

谷歌还没有想好怎么革自己的命,一直如履薄冰,在应用上还没有拿出*的方案,把iPhone时刻拱手让给了微软。

03、应用层涌现,小模型也大有可为

芯片和算力相当于锂矿和电池,其稀缺性决定了这是少数企业有条件参与的游戏。

要匹配相应规模的算力用于AI训练并非易事,因此ChatGPT概念一火,便立刻带动有关芯片、算力的股票板块。

英伟达的A100/H100是目前最强大的数据中心专用GPU。1万颗A100芯片被认为是AI模型的算力门槛。据国盛证券估算,按照ChatGPT1月份1300万的访问量水平,对应的芯片需求就多达3万多颗A100。

此外,ChatGPT单月运营需要算力约4874.4PFlop/s-day。拥有亚洲*超算中心的商汤科技,总算力超过每秒4910Petaflops,也就是说要训练GPT几乎得用上全部算力。

在国内,只有云厂商具备算力和AI模型的基础条件。在这个性能快速提升的领域,先发优势可能会给后边的企业带来不可逾越的鸿沟。

AI大模型对于云计算行业将发挥game changer的作用,按李彦宏的话说,以前更关注的是基础算力,而现在需要考虑的则是芯片、模型、框架协同做得好不好。

可以预见的是,AI大模型未来会自然渗透到各个办公、内容创作场景,新的应用正在涌现,正如石油、煤炭赋能了工业生产、交通运输等领域。

对于不想错过这一波技术红利的企业来说,站在巨人的肩膀上,成功概率也许更大一些。

相比垂类行业的小模型,大模型具有广泛的迁移学习能力,就像人类把骑自行车的能力迁移到学骑摩托车一样,比如在金融领域习得的知识可以迁移到税务会计等其他经济场景里。

但在大小模型联动的学习方式里,小模型可以通过知识蒸馏从大模型中学习,并可以在许多下游任务中达到与大模型相似的性能,就像老师带着学生。

同时,AI模型+文本&对话&图像&视频&代码等多模态的实现,让AGI有在影视娱乐、游戏、电商零售、广告营销等商业场景具有成为专家的能力,能够大幅降低内容创作的门槛,带来生产力和成本的优化。

因为API的开放,大模型根植于更多已经成熟的商业模式,场景和用户规模正在大幅扩展。许多已经积累了大量用户的应用结合api对产品形态进行了升级,包括移动端App以及浏览器插件,被分流到各类应用的用户一旦成为AI使用者,其规模必将是指数级的增长。

04、尾声

许多看过《2001太空漫游》的人应该都对电影开头那个史诗级的蒙太奇影响深刻:

开头两分钟的镜头展示了人类祖先的生活面貌,猿人*次了解到骨头如何作为工具使用,开启了智性。当白色的兽骨扔到空中时,瞬间切成了遨游在太空里的孤寂的宇宙飞船。

这一幕匹配剪辑仅用几秒钟的时间,就完成了人类进步的跨越。几秒钟的时间,对于宇宙来说无甚区别,但对于人类则是长达几十万年的进化。

在占比不到1%的技术文明浪潮中,人类的知识和财富呈现爆炸性增长,这是由技术驱动创新带来的结果。

过去几十年,关于智能的定义一直在不断的被修正,在这一轮技术革命中,AGI不会缺席。