图像分割技术是计算机视觉领域的重要研究方向,也是该领域其他应用的一个重要前期步骤。近些年来,随着深度学习技术的逐步深入,图像分割技术有了突飞猛进的发展,尤其在场景物体分割、人体背景分割、三维重建等技术在无人驾驶、增强现实等城市数字化领域得到了广泛应用。而近日,特斯联科技集团首席科学家兼特斯联国际总裁邵岭博士及团队提出具有语义对齐的多级表征学习框架解决指定视频目标分割(Referring Video Object Segmentation, RVOS)中存在的问题,在该领域形成科研突破,且相关研究成果(标题为:Multi-Level Representation Learning with Semantic Alignment for Referring Video Object Segmentation)已被2022年的人工智能领域*会议CVPR(国际计算机视觉与模式识别会议)收录。

总体而言,该项研究突破可概括为三个方面:首先,提出了一个基于多级表征学习的RVOS新框架。它通过更丰富、更结构化的视频表征,排除了单帧建模的局限性,保证了更加精准的语言-视觉语义对齐;第二,引入了动态语义对齐(DSA),它在匹配语言语义与不同级别的视觉表征时采用了更有效的自适应对齐;第三,该方法在两个具有挑战性的数据集上实现了引人注目的表现,包括Refer-DAVIS17和Refer-YouTube-VOS。值得注意的是,对于Refer-DAVIS17上的J,该方法比*的单帧建模方法获得了6.6%的显著提升,同时在两个数据集上实现了53.2FPS的高推理速度。

指定视频目标分割(RVOS)是一种广泛应用于视频编辑、虚拟现实和人机交互的 AI技术,旨在基于特定自然语言表达,从视频中预测最相关的视觉目标。与常规的无监督或半监督视频目标分割相比,RVOS需要实现语言文本和视频内容之间的跨模态理解,而不是通过视觉显著性或关键帧标注来定位目标。

帧级建模两大局限性致 RVOS精确度较低

我们可以通过人类认知系统简单理解跨模态数据的含义。当人类在语言的引导下识别一个目标时,通常会采用三个步骤:1)观察目标的外观和方位(即基于帧),2)翻看多帧观察目标的运动状态(即基于视频),3)将更多的注意力转移到遮挡或较小的目标上(即基于目标)。

目前,大多数方法只是简单地将基于图像的方法应用于视频跨模态理解。它们或者使用指定图像定位(referring image localization)来生成目标边界框作为提案,或者直接使用指定图像分割(referringimage segmentation)。然而,与人类认知系统相比,这些帧级建模方法存在两个局限性:忽略长时信息,缺乏对空间显著目标的关注。

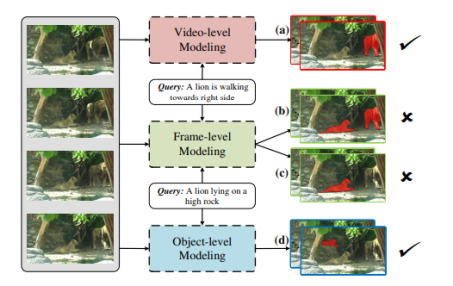

前述局限性导致了视觉和语言两种模态之间的错位,进而产生不准确的分割结果。举例来说,如图1所示,当我们给定一个输入视频及其对应的描述,比如“一只狮子正在向右行走”时,RVOS的目标是从视频中分割出运动的狮子。但由于视频中有多个狮子,仅利用单帧外观信息无法识别出正确的狮子(如图1(b)所示)。在这里,语言所指的目标具有时间上的运动状态,因此需要观察多帧来识别特定动作。此外,“狮子卧在高高的岩石上”指的是被遮挡的小狮子。然而,帧级建模只关注每一帧的全局语义,而忽略了一些更重要的、更具有代表性的视觉区域,这也会导致指向错误的目标(如图1(c)所示)。

图1. 不同建模之间的视觉比较。简单的帧级建模难以识别运动目标(b)或被遮挡的小目标(c)。相比之下,多级建模提供了一种联合方式来利用长时信息和空间的显著线索进行跨模态匹配,从而提供更准确的结果(a)(d)

具有语义对齐的多级表征学习框架

在这样的背景下,邵岭博士团队提出了全新的多级学习框架来解决RVOS问题。该模型首先对视频内容进行细粒度分析,以实现多粒度的视频表征:

•在视频粒度上,建议使用跨帧计算对整个视频的长时依赖进行建模,让视觉表征得以捕捉目标的运动或动态场景信息。

•在单帧粒度上,采用自注意力机制整合帧内信息,从而描述整个图像中的全局内容。

•在目标粒度上,借助目标检测器来增强前景和背景的可分辨性,解决遮挡和小目标的情况。

在实现多级(或多粒度)视觉表征之后,团队提出动态语义对齐(DSA),使它们与语言特征交互。为了有效捕捉特定粒度的语言信息,团队首先根据不同的视觉线索分别生成对应的基于视觉粒度的全局语言语义。再将生成的视觉语言特征与相应的视觉特征相结合,为所指目标提供特定粒度下的目标表征。最后,团队整合多粒度下的目标表征和边界信息,使用边界感知分割(BAS)引导所有帧的分割预测。

具有语义对齐的多级表征学习经实验验证,效果优于其他竞争方法

团队亦分享了基于前述解决方案与两个流行的RVOS数据集进行的定量及定性对比实验,即:Refer-DAVIS17和Refer-YouTube-VOS。

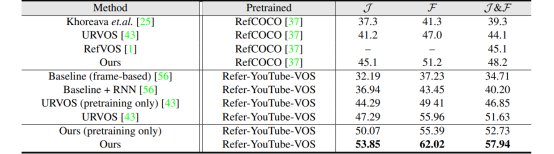

Refer-DAVIS验证集:在用Refer-DAVIS进行训练之前,团队在大规模的Refer-YouTube-VOS训练集中对模型进行预训练,并在Refer-DAVIS验证集中对模型进行了性能测试。如表格1所示,在相同的“仅进行预训练”情况下,提出的方法与最新的模型URVOS相比有显著的性能提升(J:+5.8%,F:+6.0%)。在Refer-DAVIS训练集里对预训练模型进行微调后,提出的方法在所有指标上都大大优于所有竞争方法(与URVOS相比,J:+6.6%,F:+6.1%)。此外,团队还提供了其模型在指定图像分割数据集RefCOCO上进行预训练的结果,其得分高于URVOS和RefVOS等基于帧的方法。

表格1.Refer-DAVIS17验证集的定量评估,含区域相似度J,边界精确度F,J&F的平均值

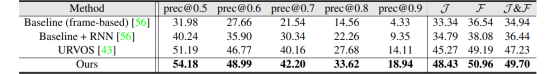

Refer-YouTube-VOS验证集:我们可以进一步观察新方法在Refer-YouTube-VOS验证集上的性能。如表格2所示,其模型在所有指标上都显著优于SOTA。与URVOS相比,该模型将区域相似度J提高了3.1%,轮廓精度F提高了1.8%。这一方法在精度上也获得了更高的分数(例如,prec@0.8:+5.0%,prec@0.9:+4.8%)。以上两个数据集的结果均表明了具有语义对齐的多级表征学习的优越性。

表格2. Refer-YouTube-VOS验证集的定量评估,含区域相似度J,边界精确度F,J&F的平均值,和成功百分比(prec@X)

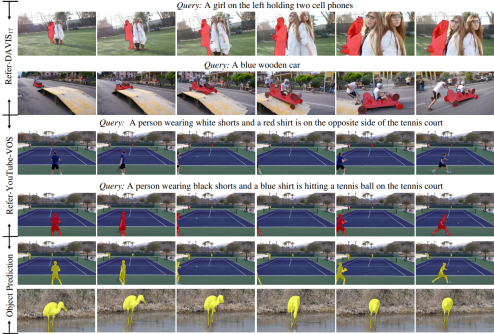

此外,论文还分享了其方法的一些典型视觉结果(如图2所示)。在*个序列中,摄像机的移动让视频中的女孩出现了尺寸变化。在第二个序列中,蓝色木车向前移动,由于外观变化很大,难以进行准确估计。第三和第四个序列来自同一个视频,但由于局部遮挡和背景中视觉上相似的对象而更具挑战性。尽管如此,该模型还是成功地分割出所有的目标。总体而言,得益于在视觉—语言理解过程中考虑了多级表征,提出的模型得到了出色的指定视频目标分割结果。

图2. Refer-DAVIS17验证集和Refer-YouTube-VOS验证集的定性结果。前四个序列代表指定视频目标分割结果,最后两个序列是显著目标预测结果

除指定视频目标分割结果外,文章还在图2中提供了一些显著目标预测结果。可以看出,所有目标预测都带有清晰的边界,包括被遮挡的和小的目标,这表明显著目标的生成可以提供关键的先验目标信息。

总体而言,在这项最新研究中,邵岭博士团队提出了一种新颖的多级表征学习框架来处理RVOS任务,通过编码视频、单帧和目标级语义,提供了一个强大且信息丰富的视觉表征;通过引入动态语义对齐机制,对不同模态可以进行自适应融合。这一研究突破可以进一步提升视频目标分割的精确度及效率,使相应技术得以高效应用于城市中包括安防、应急等场景。