Facebook改名Meta后,“财务厄运”并未因此终止,但技 术作风却一如既往的大胆。

虽然自2022年2月以来,公司股价已下跌30% ,市值损失超过2500亿美元。但是,这并没有影响开发者们的精神世界与工作动力。

本周,来自Meta一小撮程序员的疯狂举动,在全球AI开发者群体中引发了巨大骚动——

Meta AI 实验室高调宣布,将开放自己的语言大模型 OPT(Open Pretrained Transformer,预训练变换模型),毫无保留地贡献出所有代码。

不夸张地说,在人工智能圈,这算得上是一个里程碑事件。

这个被称为OPT的大规模语言模型,自建立以来,各项参数与能力便精准对标OpenAI 的GPT3,甚至连缺点都是。后者在全球学术界建立的赫赫声望和随处可见的网络小说续写作品,想必已不必再过多赘述。

简而言之,这是一种利用巨量网络文本与书籍进行训练,可以将单词和短语串在一起组成精彩文本的深度学习算法模型。

它能生成复杂句子,有时候甚至读起来与人类撰写毫无无异(想粗浅了解GPT,可以看这篇《让00后疯狂的超级算法》)。某种程度上,它所具备的神奇人工文本模仿能力,被视为人类通往真正机器智能道路上的一个巨大突破口。

GPT3生成的文本

然而,“培育”大模型的代价,是昂贵的人力成本与成千上万块显卡。因此,许多学者都认为,把这种大模型开放出来,几乎不可能发生在“游走在垄断边缘”的大型科技公司身上。

譬如,OpenAI 的GPT3曾被专家粗略估算过,至少投入了1000万美元。他们后来为了摆脱入不敷出的现状,将GPT3作为一项付费服务来推广——只提供API,但不会开放模型本身和底层代码。

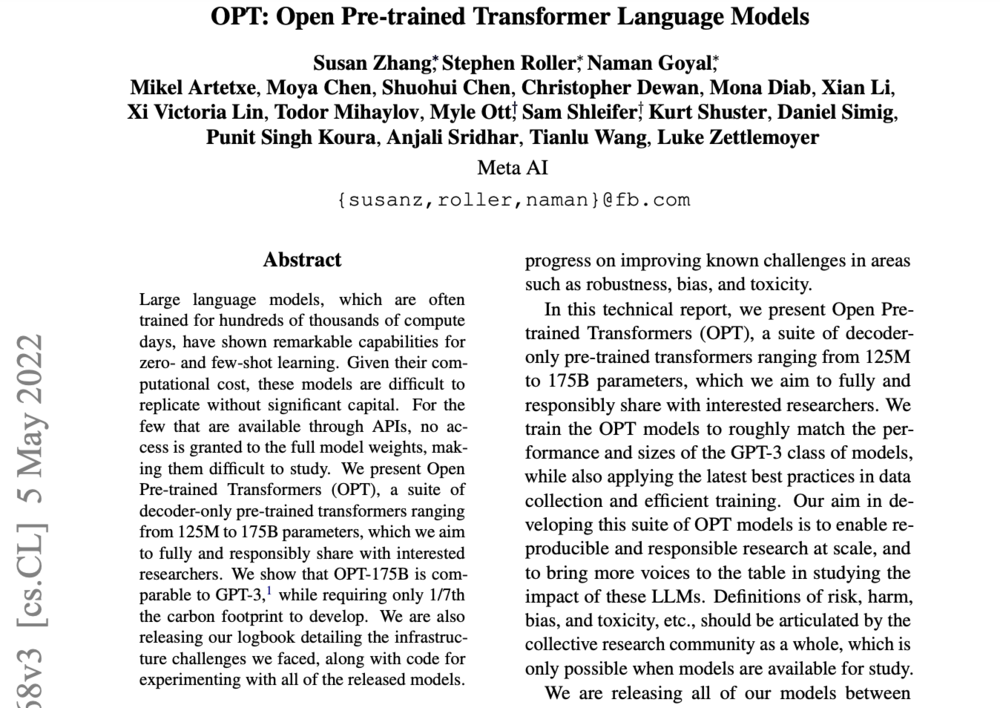

然而,Meta表示,会把不同参数规模的训练模型以及“OPT如何建造和训练”的详细信息分发给研究人员。

其中,也包括一份超过100页的算法训练日志——实验室记录下的每一个错误与崩溃现象,训练和添加数据的过程,以及有效与无效策略。

“考虑到计算成本,如果没有大量资金,这些模型很难复制。对于少数通过api可调用的模型(这里暗指GPT3),如果不能获得完整的模型权重,就难以进行研究。”他们在OPT的论文摘要里鲜明表达了态度,

“因此,我们推出了OPT(这是一个只有解码器的预训练变换模型),参数范围从125M到175B,目标是全面且负责任地分享给感兴趣的研究人员。”

“是真的开放。”

一位“正准备去看看他们实现情况”的中国开发者查阅了MetaAI网站后,告诉虎嗅,这的确是一个好消息。“从现有数据来看,整个训练代码都被贴出来了。Meta很了不起。”

擅用集体力量

这一次开源,毫无意外受到了学术界的高度认可,甚至有科学家称其是一个伟大的举动。

究其原因,一方面,一项强大技术,如何在一个封闭的企业精英团队中诞生,一直是包括学界在内大众好奇的焦点;

另一方面,“开源”的优势在于利用集体力量来解决问题,因此长期被硅谷的有识之士所倡导——更多人参与进来,技术突破便来得越快,漏洞便填得越快。

尽管大部分人几乎只记住了GPT3(因为它是迄今为止*的“通才”),实际上,除了Meta,谷歌、微软都曾在2020年都推出过相似的大模型,但由于都是“关起家门”做私密研究,因此在“透明度”方面饱受诟病。

譬如,2021年的“谷歌人工智能伦理学科学家辞退事件”便引发了长达一年的“批判海啸”,而这一切都是因一篇探讨“语言大模型暗藏重大隐患”的论文而起。

没错,GPT3们不仅缺陷多多,而且非常致命。尽管多数责任应归咎背后的人类文本。

创业公司 Latitude 曾在2019年推出过一款基于GPT3开发的半开放冒险游戏 AI Dungeon。但没想到,随着用户增多,OpenAI监测到,有玩家竟然利用这项高阶技术,自发生成儿童性爱场景。

虽然用户利用GPT3生成的污言秽语也曾遭遇过广泛抨击,但这件事仍然让大众哗然。这也是外界*次意识到,GPT3这类大模型更为深刻的阴暗面。因此,Latitude增加了审核系统,但却引发了与用户体验相关的一系列麻烦。

然而,“越是危险,越不能回避危险”。这也是Facebook自称选择开放的关键原因之一。

Meta AI 负责人Joelle Pineau承认,团队解决不了所有问题,包括文本生成过程中的伦理偏见和恶毒词句。因此,他们诚邀天下豪杰,共同学习;而实际上,这也是一种彼此监督。

“我认为,建立信任的*途径是极端透明。”

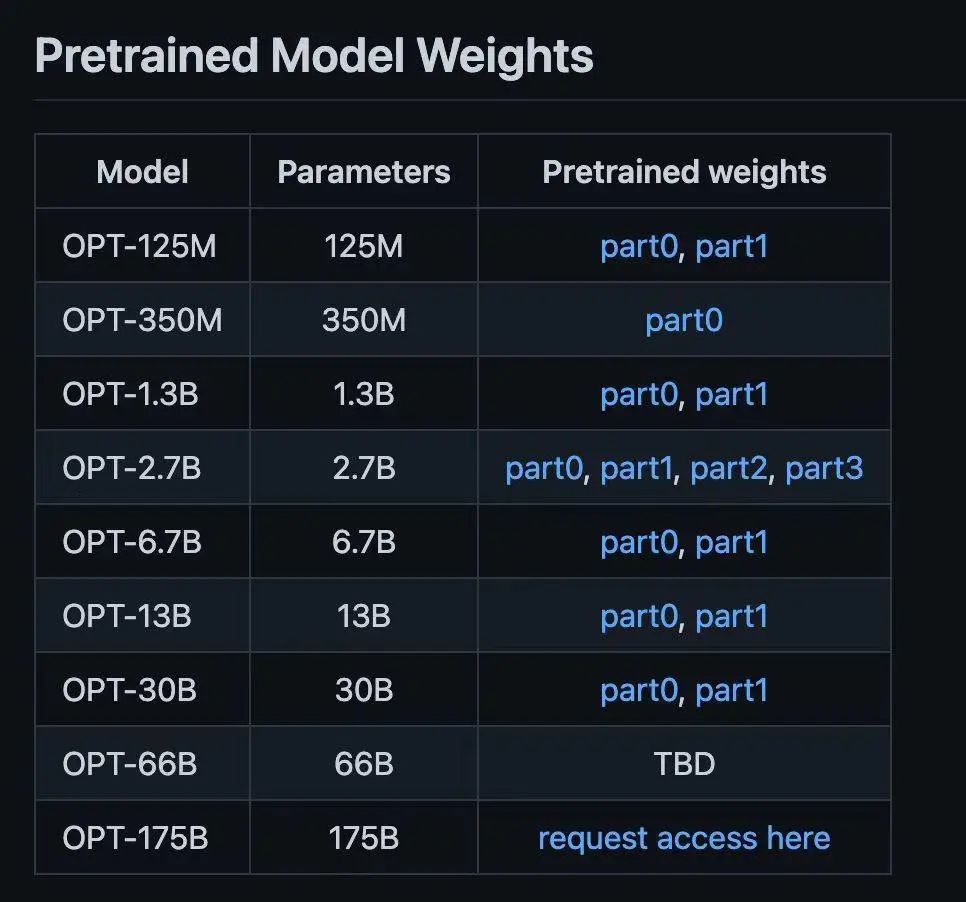

我们查看了Meta提供的下载通道,发现实验室根据每个模型的参数规模设立了不同的下载条件:300亿参数以下可随意;而1750亿参数值模型,也就是与GPT3大小相同的OPT,则需要填写申请表证明用于非商业用途,获得批准后方可下载。

翻过大山,仍然是山

当然,理论上这个做法是可圈可点的,但一个更大的问题出现了:如果你要使用这个1750亿参数值的大模型,就意味着你的计算机要带得动它。

换句话说,你需要拥有足够的算力,这里可以直接换算成“财力”。

“一个参数如果是FP32,也就是4个字节大小。而1750亿参数值则相当于7000亿字节,大约700G显存空间。而现在一张普通显卡是20GB。” 一个开发者向虎嗅称赞了Meta的做法,但他认为,对于普通开发者群体,该模型仍然是不可承受之重。

“虽然可以把不同参数放在不同显卡里的框架里,但据个人体验,目前仍然欠缺开源成熟的框架。”

因此,截至目前,这个开源大模型,仍然是属于大型科技公司、拥有充足资金的大型实验室与学术机构的“内部游戏”。

曾有家尝试做中国版GPT3的创业公司叹息说,他们也在想方设法实现GPT3可以实现的文字能力,但的确掣肘于有限算力。

事实上,除了巨头,GPT3一直难以解决的商业化难题,是让绝大部分企业呈观望之势的根本原因。尽管大型语言模型已成为过去几年来人工智能领域最热门的趋势之一。但至少目前来看,除了品牌营销优势,OpenAI 的投入产出比,很不尽如人意。

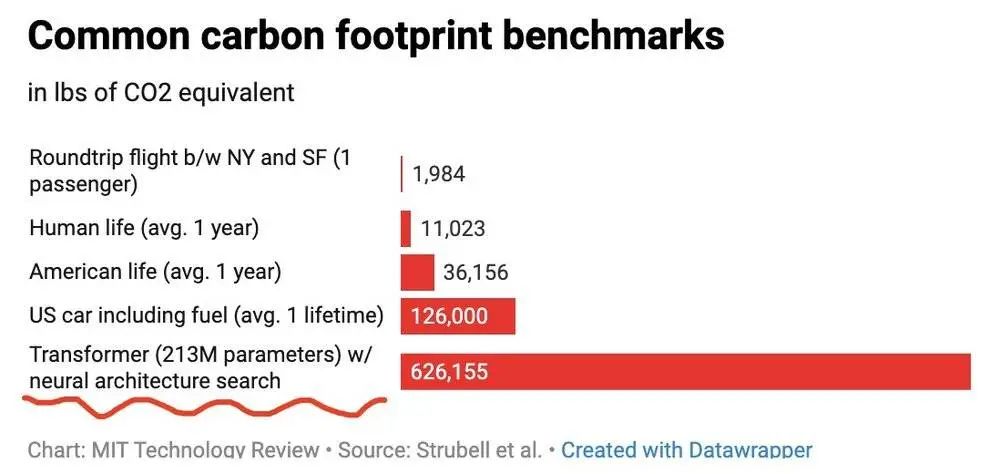

图片来自MIT

此外,在西方社会普遍认知中,比起技术突破,它们带来的巨量能源消耗更是一种原罪。

科学家Emma Strubell与合作者在2019年发表的论文,就揭露了大型语言模型在碳排放上超乎想象的环境破坏力(上图)。

他们发现,用一种神经结构搜索方法(NAS)训练出的特定语言模型,可产生284吨(626155磅),上图)二氧化碳,这大约是5辆小轿车长达5年的排放总量;

而谷歌搜索引擎的基础——BERT语言模型训练,则产生了0.65吨二氧化碳,Strubell提醒,这相当于一个乘客从纽约到旧金山往返航班的碳排放量。

更需要注意的是,这些数字都应被视为“最保守数值”:只是在一次性训练中的模型成本。

因此,考虑到能源效率与环境成本,西方不少科学家与开发者认为,某种程度上,大模型的训练开发也是在允许大型企业掠夺着环境资源,而这些成本,将会平摊在所有人身上。因此,他们并不希望企业加入到大模型队列中。

“尽管是无意识的,但这只会加大对边缘人群的打击。”

开源商业回报,巨大且无形

很多时候,人们会对开源模式发出这样的质疑:

有什么能比“两个来自竞争对手公司的员工,可以为同一个目标协作,还免费送出自己成果”更不可思议的事情?

譬如,可能连小学生都清楚的安卓系统,就是基于开源的Linux操作系统。这意味着,任何人都可以查看绝大多数安卓手机的核心代码,修改并分享它。

事实上,“开源”正是为不同利益群体,提供一种“利远大于弊”的长期技术合作方式——你增加的独特元素我能使用,那么我迭代的版本你也不会错过。

这种“互利”态度,让看似不可思议的“协作”成为可能,经过100多年来的反复修正,早已成为一种常态。如今,Linux 就是由全世界超过15000名程序员共同开发和维护。

而在人工智能领域内,最有名的案例则是谷歌的深度学习开源框架Tensorflow。它已是开发人工智能应用程序的标准框架之一。非常有趣,当Tensorflow在2015年开源时,外界也是发出了跟这次Meta开源大模型同样的疑问:

作为开放者,谷歌为什么要放弃对自己搜索业务如此重要的东西?

一部分原因上面讲过——外部开发人员把软件做的更好,该软件就能适应谷歌未来商业化的很多需要。就像当下,大模型商业化还尚不明朗,那么前期工作的开放性与主导性,就变得至关重要。

根据谷歌自己公布的数据,已有超过1300名外部人员在TensorFlow上帮助升级迭代。而完善后的Tensorflow,则为谷歌云上的相关付费服务输送了强力支持。

另外,我们永远不要小看开源软件为企业带来的巨大营销价值。

它最一流的“带货效果”,便是吸引和留住一众*人才,不知道为大厂省下多少高昂的人力资本。这也与当下Meta开始收缩招聘规模的现状,做了*呼应。

当然,优秀开源软件打的时间差和聚拢效应,将会使后来者很难在短时间内形成气候,Tensorflow与一众国产深度学习开源框架的往事就是*的例子。

因此,Meta这一决定,将会让OpenAI陷入一个尴尬的境地——虽然名声很大,但它毕竟是一家创业公司。从另一个角度看,在寻找商业落地的过程中,大厂通过开放、免费等手段遏制对手,取得胜利,这种事情似乎永远都在发生。

但好处在于,这会让一家公司意识到,在商业世界,没有一分钟时间可用来顿足,绝不能停下创新的狂奔步伐——近期他们发布的达利系统第二代,也许是以GPT3为跳板,向文字与视觉融合方向跃升的*标志。