就在刚刚过去不久的九月底,有“ChatGPT最强平替”之称的Anthropic拿到了亚马逊的一笔总价40亿美元的投资,之后不久他们就发表了一篇论文《朝向单义性:通过词典学习分解语言模型》(Towards Monosemanticity: Decomposing Language Models With Dictionary Learning),在这篇论文里详细阐述了他们解释神经网络与大语言模型(经常被简称为LLM)行为的方法。

Anthropic之所以能有“ChatGPT最强平替”的别名,主要是因为其创始成员几乎都参与开发过GPT系列的早期版本,特别是GPT-2和GPT-3。而众所周知GPT系列真正引人关注是从GPT-3之后的3.5开始的,老话说“罗马不是一天建成的”。而且Anthropic的AIGC产品Claude与ChatGPT相比也不逊色多少,今年夏天推出了最新版Claude 2,英国《卫报》对此评论称“训练时以安全性为首要考虑,可以称为‘合宪式AI’或‘合宪式机器人’”,一个全新的AI或机器人分类与研究也可能就将由此开启。

现在市面上流行的LLM基本都是基于海量的神经网络而打造,而神经网络又是基于海量数据训练而来。在此基础上的AIGC,如文本、图片、视频等多模态或跨模态内容,虽然也可以保证可观的准确性且数量上也日益丰富,但可解释性始终是难以突破的难关。

举个例子,现在随便找个AI问1+1=?它们都会说1+1=2,但都无法解释这个过程是如何产生的。即便能进行简单解释,也只是基于语义上的肤浅理解。就像我们人类睡觉时的梦境一样,人人都会做梦也都能大致说出梦境内容,但对梦境的成因几千年来始终都没有合理和统一的解释。

ChatGPT等LLM经常出现无序、混乱、虚假信息等情况,这种行为被称为“AI幻觉”,也就是常说的一本正经的胡说八道,主要是因为人类无法控制AI与大模型内的神经网络行为。所以Anthropic的研究对于增强LLM,甚至AI与大模型整体的准确率、安全性,降低有害内容输出的帮助都非常大,这篇论文还是很有参考和借鉴意义的。

论文链接:https://transformer-circuits.pub/2023/monosemantic-features/index.html#phenomenology-feature-splitting

01 关于神经元与神经网络

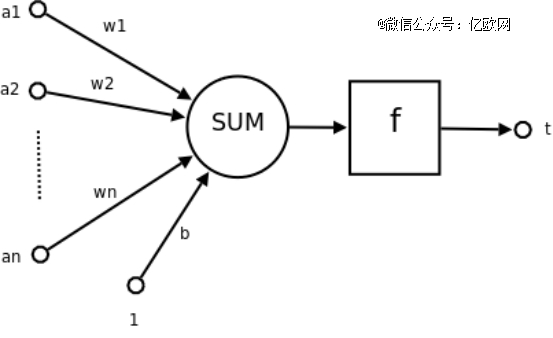

为了更好地理解Anthropic研究的意义,这里先简要介绍几个基本概念。神经元是神经网络的基本组成部分,主要对数据进行输入、计算和输出。它的工作原理是对大脑神经元工作方式的模拟,接收一个或多个输入,每个输入都有一个对应的权重。这些输入和权重的乘积被加总,然后加上一个偏置项。得到的总和被送入一个激活函数,激活函数的输出就是这个神经单元的输出。

神经元工作流程示意图,其中a1-an为输入向量的各个分量,w1-wn为神经元各个突触的权重值,b为偏置项,f为传递函数,通常为非线性函数,t为神经元的最终输出结果

前面说过神经元是神经网络的基本组成形式,一定数目的神经元就可以组成一个神经网络。这种系统源于对人类中枢神经系统的观察研究与逆向应用,最初的概念早在上世纪40年代早期就提出了,1956年在一台IBM 704电脑上进行了首次实践,但此后就陷入沉寂,直到1975年“反向传播算法”的发明,80年代中期“分布式并行处理”的思想(当时称之为“联结主义”)开始流行,又促使社会各界再次开始重视神经网络。进入新世纪后,特别是2014年出现的“残差神经网络”概念,极大的突破了神经网络的深度限制,随着“深度学习”概念的提出和流行,神经元与神经网络也水涨船高的愈发引人注目。

02 对LLM等大模型的重要性

前面说过现在的LLM和大模型、AIGC等,基本都要依赖神经元与神经网络才能发展壮大,能说会道的ChatGPT也正是依靠Transformer的神经网络架构开发而来。LLM使用神经网络来处理和生成文本,在训练过程中,它们会学习如何预测文本序列中的下一个词,或者给定一部分文本后续的可能内容。为了做到这一点,LLM需要理解语言的语法、语义、以及在一定程度上的上下文。

概括来说,神经元与神经网络提供了处理和生成自然语言的计算框架,而LLM则通过这个框架来理解和生成文本。这也是很多人对目前的LLM,AIGC,甚至整个AI的原理都概括为“概率论+魔法”的主要原因之一。

客观看来,这种说法有些偏激但的确也有道理,因为目前的大部分大模型,包括GPT系列在内,它们的生成原理的确可以这么归纳。

前面说过AI的工作方式可以视为对人类大脑工作方式的逆运用与模仿,而GPT之类使用的黑盒系统也在结构上模仿大脑,由海量的神经元组成。因此要想说明“可解释性”就必须要了解每个神经元在做什么。

03 Anthropic的研究

Anthropic的研究是基于Transformer模型进行的一次小规模实验,将512个神经元分解成4000多个特征,并逐个分类排序,比如DNA序列、法律专业术语、HTTP请求、营养说明等。经过试验和研究后发现,单个特征的行为比神经元行为更容易解释且可控,同时每个特征在不同的大模型中基本上都是通用的。

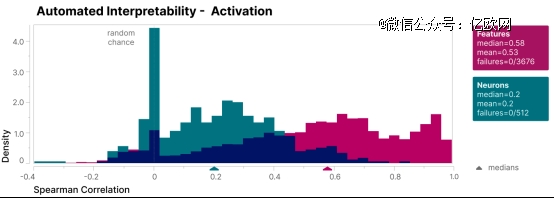

为了验证这一研究结果,Anthropic还创建了一个盲评系统,来比较单个特征和神经元的可解释性,由图中可见特征(紫红色)的可解释性得分要比神经元部分高了不少(青蓝色)。

此外Anthropic还采用了自动解释性方法,最终的结果也是特征得分高于神经元得分,不过这种方法较为复杂,此处不展开,详见其论文。

Anthropic的这项研究的确意义非凡,不过早在几个月前,OpenAI也曾做过类似的事情。在今年五月初,OpenAI在官网发布博客文章《语言模型可以解释语言模型中的神经元》(Language models can explain neurons in language models),其中说到:“我们使用GPT-4自动编写LLM中神经元行为的解释,并为这些解释评分,现在将GPT-2中每个神经元的这些(不*的)解释和分数的数据集公布出来。”当时读过这篇论文的人,几乎都为OpenAI的奇思异想而感到震撼,头皮发麻。

当时之所以有这项研究,主要是为了回答ChatGPT火遍全球的同时引起的一个问题:“发展到今天这一步,AI是怎样实现这么强大的功能的?”

为了回答这个问题,OpenAI当时的做法可以简单的概括为“用黑盒解释黑盒”。而且OpenAI的这次研究成果,倒也不失为后续AI与大模型等相关企业进行研究探索了新的方向,自然意义非凡。前面说过AI可以视为是对大脑工作原理的逆运用,而LLM等大模型都使用的黑盒结构也都由海量神经元组成,也是在模仿大脑。

当时OpenAI给出的解释过程分三步:

给GPT-4一个GPT-2已有的神经元,由GPT-4展示相关的文本序列和激活情况,产生一个对此类行为的解释;

再次使用GPT-4,模拟被解释的神经元会做什么;

比较二者的结果,根据匹配程度对GPT-4的解释进行评分。

最终OpenAI表示GPT-4解释了GPT-2中的全部约30万个神经元,但是绝大多数的实际得分都偏低,只有勉强一千多个的得分高于0.8,这意味着神经元的大部分*激活行为都是这一千多个神经元引起的。

看来AI或许也在有意无意间遵循“二八定律”。当时这项研究成果很快在全球各大技术平台也引起了广泛关注。有人感慨AI进化的方式愈发先进:“未来就是用AI完善AI与大模型,会加速进化。”也有人批评其得分甚低:“对GPT-2的解释尚且如此,那如何了解GPT-3.5和GPT-4内部结构呢?但这才是许多人现在更关注的答案。”

虽然电脑是模仿人脑的原理而发明,但人脑的结构其实并不高效,比如没有存储设备,神经元的通讯也是通过激素或荷尔蒙等化学方式来进行,相当的别扭。这种“落后”的“元器件”竟然能给人类如此高的智慧,说明人脑的强大主要在于架构。

当前探索智能的本质也是脑科学研究的中心任务之一,是了解人类自身、解密思维与智能成因的科学探索需要。脑科学与AI息息相关,既可以提升我们人类对自身奥秘的理解,也可以改善对脑部疾病的认知水平,同时相关科研成果也可以为发展类脑计算,突破传统电脑架构的束缚提供依据。

但在当下,类脑计算还具有着巨大的空间,等待着科研力量填补。当下千亿量级参数的大模型已经屡见不鲜了,如果把参数看成神经的突触,大模型对应人脑的神经元,只有1亿个。而1亿个神经元与人脑千亿级别的神经元,中间的差距有千倍之多,而这一差距或许也是走向AGI人类科学必须跨越的鸿沟。

OpenAI和Anthropic做的这些研究,也在无形中给我们的科学技术进步展示了一种可能性:当未来对的AI变得越发强大,甚至有一天真的超越人类,它也能在后续更多的前沿科技上为人类提供帮助;而对智能的研究,在生物大脑之外也有了AI系统作为新的研究对象,这也为破解智能之谜带来了新的希望。