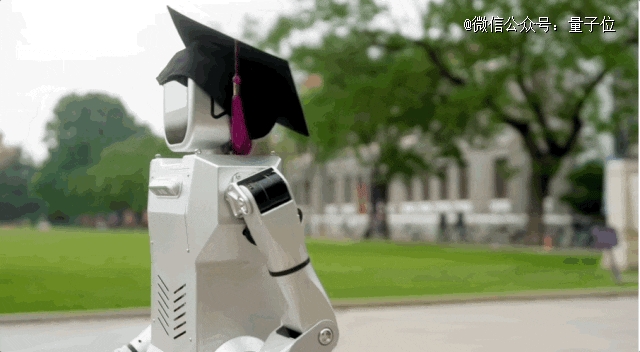

这年头,人形机器人都有清华的学士帽戴!

这位走出清华二校门的机器人,简直要把门口参加暑期研习营的小孩们馋哭了。

不仅拥有清华紫学士帽,在刚刚结束的WAIC“具身通用人工智能”论坛上,这个名叫小星的人形机器人,还和图灵奖得主、中国科学院院士姚期智合影贴贴。

是谁羡慕了?我不说。

小星这“人”,出自清华大学交叉信息研究院(IIIS)陈建宇团队,整机结构、电机、减速器、驱动器、步态算法等机器人软硬件将通通自研。

陈建宇,31岁的清华叉院助理教授,28岁时,就已经以叉院博导的身份走在从教之路上。

博士毕业于UC伯克利,本科就读于清华大学精密仪器系,研究领域包括机器人学、强化学习、自动驾驶等。

人形机器人小星

一起来认识一下,这位青年博导“教”出来的人形机器人——

体重28kg,身高1.2m,加上双手后,全身上下具有34个自由度。

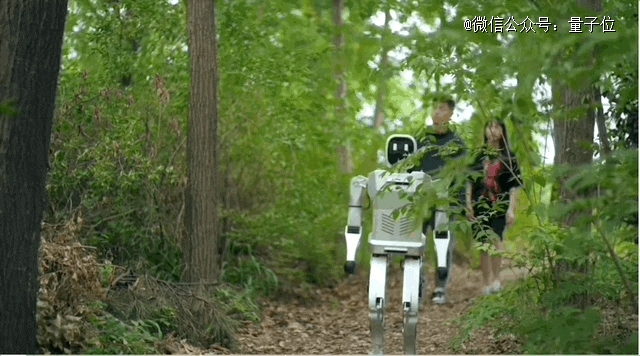

在行走方面,小星在不同类型的地面上都可以稳步前进,比如落满枯叶的林间小道:

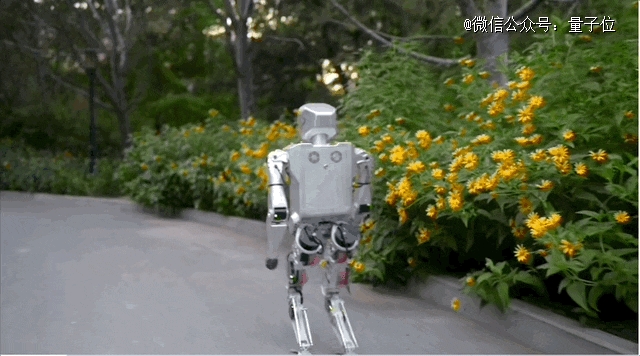

或者是公园花坛旁的水泥上坡路:

脚下的地皮换成草坪,也不妨碍它踏步前进:

总之就走得还挺稳的,速度也还不错。

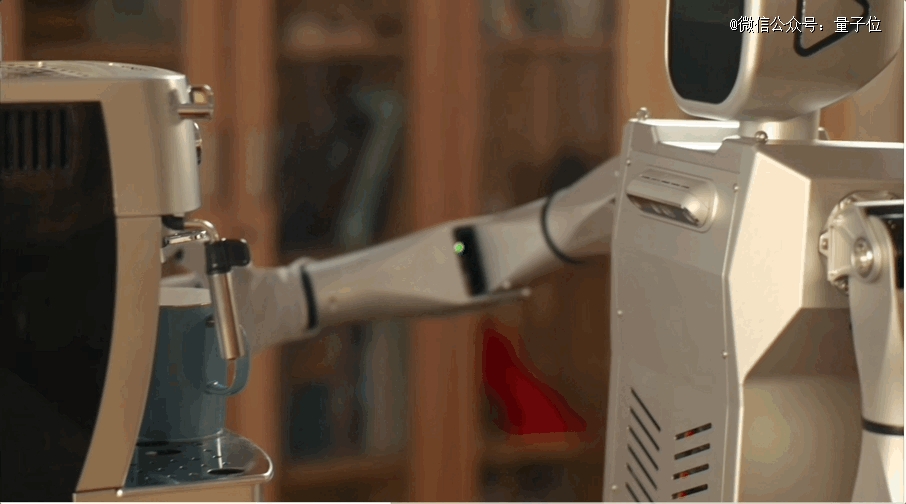

与此同时,它还能利用双手提供一些服务功能,递个烧烤、端杯咖啡什么的:

在液压驱动和电机驱动二者之间,小星采用了成本优势更高的后者。

为了研发高性能、低成本的人形机器人,团队坚持最新一代的准直驱力控方案,用高扭矩密度电机搭配低减速比减速器,用电流环直接力控搭配动态双足行走算法。

这种方案对电机扭矩要求极高,因此团队也一直在探究新的电机设计方案。

目前所研制的电机扭矩密度已达到了30Nm/kg,是TQ电机(目前工业界最强)的两倍以上。

如此一来,无论是行走还是摆臂动作,小星都能保持在一个比较灵活的状态。

不过,陈建宇也坦然表示,目前小星机器人硬件上搭载的算法智能性还不够高,小星的现阶段表现,还没有发挥硬件可以支持的极限。

因此,团队的另一项主要工作就是推进前沿的机器人智能算法,目前走的是动力学模型+优化控制和物理仿真+强化学习这两条机器人领域最前沿的路径。

相比于传统的机器人算法,二者都更为通用,并且可以更多地利用动力学来提高性能。

这两大方法也是陈建宇博士期间的主攻研究方向。

2017年,陈建宇提出了一系列实时轨迹优化算法并成功应用于无人车上。

从2018年起,陈建宇的研究重点转向了更为前瞻的方法——深度强化学习算法。在这一阶段,他做出了领域内较早的几个基于自学习方法的复杂道路环境自动驾驶工作。

“从数学上来说,无人车也是一类机器人,我们研究的算法对于无人车和机器人来说都是通用的。” 陈建宇表示,在无人车时期关于强化学习的经验,不少都可以迁移到人形机器人的研究上,“当然,无人车和人形机器人的关注点不全相同,比如无人车在底层控制方面相对简单,而对上层的决策规划和交互等关注较多”。

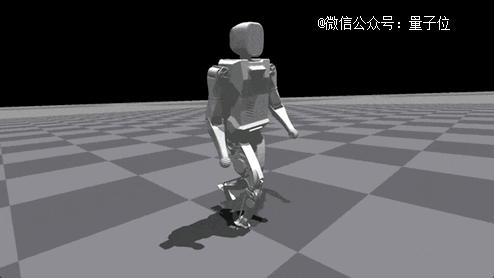

通过强化学习结合人体运动数据,小星在高精度物理仿真中学会了高度拟人的步态行走:

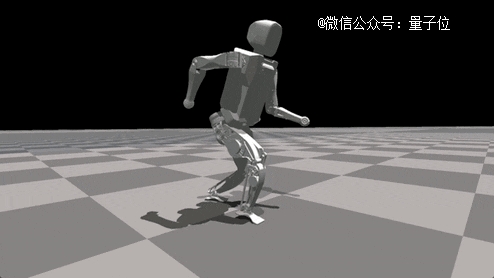

还能挖掘出硬件的极限性能,达到4m/s的奔跑速度:

除了灵活的双腿,小星的双手也很灵巧。

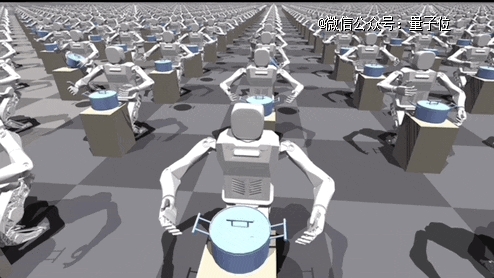

通过大规模并行仿真强化学习训练,小星学会操控其二十多个自由度的双臂灵巧手来完成各类任务。

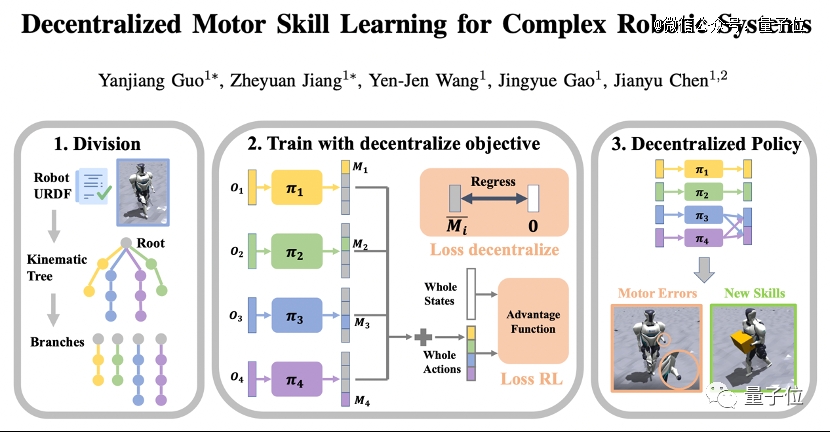

此外,为了协调小星手脚之间的协同工作,团队还提出了一种分布式技能学习算法。

“我想,人形机器人是所有机器人学家的梦想!”从本科起,陈建宇就开始关注双足步态算法,他的本科毕业设计,做的就是双足机器人落脚点规划。

2020年毕业回国,在探索过无人车、机械臂、机器狗后,于2021年底开始构思筹划研发自己的人形机器人。

筹备了半年,想通了技术路径,也就是去年春夏之交,陈建宇开启了自己的新目标:

打造人形通用机器人,以及搭载在上面的“通用智能”。

具身通用人工智能

目前人形机器人存在的技术难题是什么?陈建宇总结了最受关注的三个方面:

首先,由于人形机器人具备高度集成性和复杂性,硬件本体构建具有较高挑战性;

其次是运动小脑的构建,如何控制双腿行走和操控双臂完成各种任务,还未被很好解决;

最后是人形机器人的“大脑”,如何将目前只有语言功能的大模型拓展到物理世界,并让其进行行为决策,是实现具身通用智能体至关重要的一环。

——这就引出近期最火的技术话题之一,具身智能。

5月的ITF World 2023半导体大会上,黄仁勋在演讲中明确表态,下一波AI浪潮就是具身智能(Embodied Intelligence)。

所谓具身智能,就是能够理解、推理并与物理世界互动的智能系统,可以理解为有身体,并支持物理交互的AI智能体。

而具身智能的*目标,就是具身通用人工智能。以ChatGPT为代表的通用人工智能虽然带来了极大的轰动,但其只有语言与文本处理的能力。未来我们一定需要更加有用的具身的通用人工智能。

7月WAIC的,邀请了包括姚期智先生、Sergey Levine、Anca Dragan、Koushil Sreenath、Jiajun Wu等国内外知名大咖学者一起探讨具身AGI的未来,内容涵盖决策控制、感知认知、本体构建、算力支持、大模型理论等。

小星也在论坛上进行了现场首秀,获得了大量关注。

国际上,一些团队已在这个方向上有了初步的成果:

今年年初,谷歌推出5620亿参数的多模态具身视觉语言模型PaLM-E,可以执行各种复杂的机器人指令而无需重新训练。

哪怕受到干扰,也能完成“帮忙从抽屉里拿薯片”的指令。

李飞飞团队也新近发布了具身智能最新成果,大模型接入机器人,把复杂指令转化成具体行动规划,无需额外数据和训练。

人类可以很随意地用自然语言给机器人下达指令,如“打开上面的抽屉,小心花瓶!”

陈建宇团队也在推进这方面的研究工作。

并且做出了世界上*篇大模型结合人形机器人的学术工作。

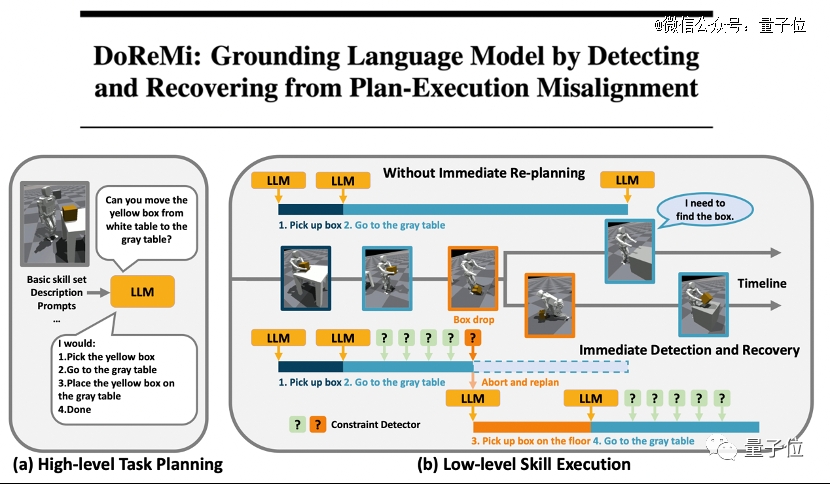

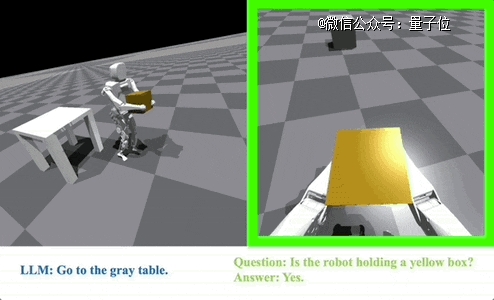

他们用大模型来指导小星的上层任务规划,用强化学习来获取小星的底层控制器。

与此同时,还提出了一套新的框架来解决上层规划和下层执行之间的对齐问题,以确保下层控制能很好地执行上层规划的任务。

“我们发现,一些简单的操作场景,接入13B的开源模型就比较够用了。”陈建宇分享了实验过程中的发现,“作为定位家庭服务的机器人,对数理逻辑、推演等功能的要求并不太高。”

紧接着,量子位又把“大模型幻觉在具身智能身上的解决思路”这个问题抛给了陈建宇。

比起网络世界里的胡说八道,现实世界人形机器人受到带有幻觉的指令,似乎是一件更为严肃、需要正视的事情。

思考片刻后,陈建宇给出了他的答案,那就是可能需要两手解决方案,一方面是大模型产品本身对幻觉的控制,另一方面,在底层的控制也要加强。

之前我在研究无人车对安全性的要求时,会设计一些方案提升无人车的行为安全,具身智能也可以采取相同的思路,在机器人收到“不安全”的指令时,及时识别,更改到安全区域范围。

所以,添加一个完全基于物理规律,类似于安全护盾的底层保护层,或许是不错的办法~