“我们都在阴沟里,但仍有人仰望星空。”——奥斯卡·王尔德(Oscar Wilde)

1968年4月11日,科幻电影《2001:太空漫游》(下称《太空漫游》)上映。这部风格诡异、剧情晦涩的电影在上映*天就引发了争议,据说好莱坞当时最红的银幕小生洛克·哈德森(Rock Hudson)跟随241位一脸迷茫的观众一起走出剧院,他的*句话就是:

“谁能告诉我这部电影到底讲了啥?”

大浪淘沙始见金。随着时间的流逝,这部当年让无数人“看不懂”的作品已成为科幻电影历史上不可绕过的传世经典。美国电影学院将其票选为影史*位的科幻片,著名科幻作家刘慈欣更是不吝于表达对原作的顶礼膜拜之情,他说:

“我所有作品都是对《太空漫游》的拙劣模仿。”

《太空漫游》诞生的20世纪60年代,是一个原子能和电子信息技术为代表的第三次科技革命爆发、理想主义盛行、人们相信科技无所不能的梦幻年代。导演斯坦利·库布里克(Stanley Kubrick)将这种情绪化作了电影史中最经典的蒙太奇之一:学会使用工具的人猿首领击败对手后,兴奋地将手中的骨头往天上一扔,镜头切换,一架宇宙飞船掠过太空。数百万年岁月流逝,科技的飞速发展,被浓缩在弹指之间。

作为《太空漫游》的粉丝,刘慈欣自然不会错过这个镜头。在他的作品《朝闻道》中,当现代人询问,几十万年前的史前人类凝望星空为什么会激发预警系统,大刘借助“排险者”之口的一句话,表达了对这个镜头的致敬:

当生命意识到宇宙奥秘的存在时,距它最终解开这个奥秘只有一步之遥了。

1

诞生:万里江山远

在《太空漫游》中,超级电脑HAL 9000的诞生地被设定为伊利诺伊州厄巴纳(Urbana)市。这座人口不到4万的小城是伊利诺伊大学香槟分校(UIUC)的所在地,也是著名的大学城。

而在多个访谈中,在计算机视觉研究中有着举足轻重的大规模物体识别和检测数据集ImageNet创始人李飞飞也提到,她对于ImageNet最初的想法,正是诞生于2006年、她在UIUC担任助理教授期间。她甚至提到2005年她刚刚博士毕业,只发过一篇计算机视觉的论文,而她能入职UIUC,很大程度上是当时在UIUC任教的计算机视觉泰斗黄煦涛(Thomas Huang,或称Tom)的大力支持,她说:

“没有他的支持,我是拿不到这个职位的。”

从上个世纪40年代创立以来,UIUC的计算机专业就是美国计算机科学研究圈子中名列前茅、仅次于CS“四大天王”的存在。1980年代,黄煦涛从普渡大学转投UIUC,UIUC也成为了美国计算机视觉研究的重镇之一。

李飞飞博士毕业于加州理工(Caltech),此前她在做博士论文时曾尝试用机器学习来探索可泛化的识别方法。在UIUC,她逐步意识到,要想避免过拟合以实现良好的泛化必须建立强大的模型。

而强大的模型需要足够多数据做支撑,但当时计算机视觉的研究都是在小数据量下进行:相比起像素及辨识不同物体所需要的特征的可能组合方式,当下计算机视觉研究的数据集——包括李飞飞自己创建的Caltech 101——都远远无法满足这一需求。

于是,李飞飞开始将研究的重心转向数据上。

2006年,李飞飞的母校普林斯顿给了她一个难以拒绝的offer——普林斯顿知道李飞飞对心理学的喜爱,特地让她可以在心理学系兼职授课。在访问普林斯顿时,李飞飞与一直从事WordNet(WordNet诞生于普林斯顿大学心理学系)研究的Christiane Fellbaum 进行了交流,并打算参考WordNet的8万个标签词的的框架,搭建一个新的数据集。

2007年1月1日,李飞飞来到普林斯顿,正式开始投入到ImageNet数据集的打造中。之后便是熟悉的故事:李飞飞获得了李凯的支持,她原打算雇佣一批本科生来进行图像的筛选,但几个月后,她发现ImageNet数据集的规模过于庞大,标注工作也遇到了瓶颈。

直到一次偶然的机会,李飞飞从一名斯坦福大学的毕业生了解到了Amazon Mechanical Turk这个在线人力市场平台,最终用众包的方法完成了Imagenet数据集。

和《太空漫游》一样,ImageNet在诞生之时也因其超前的思想未能得到广泛认可。

2009年在CVPR,李飞飞和学生邓嘉发表了ImageNet的论文,但在当时,对这篇文章并的质疑更多,包括:物体识别技术还有很多难题没有解决,发布ImageNet数据集是舍本逐末;加大数据集的规模并不一定更好。等等。

即便是李飞飞的“祖师爷”Jitendra Malik,也曾在2007年项目启动之初委婉地告诉李飞飞,他不确定ImageNet对于李飞飞申请终身教职是否有帮助,因为“你要做的事情是一项浩大的工程,但百万级别的图像并不是这个领域所关注的”。

但李飞飞对ImageNet的价值深信不疑。为让更多人了解自己的想法,李飞飞与PASCAL VOC合作,在2010年的ICCV上举办了*届ImageNet挑战赛。

PASCAL VOC(The PASCAL Visual Object Classes)是早期计算机视觉领域最重要的比赛之一。2005年举办*届比赛的数据集仅包含4类、包含2209个注释目标的1578张图片;之后每一年主办方都会陆续加入新的图片,到2009年,PASCAL VOC的数据集已扩展到20类、7054张图片;而现在有ImageNet这样更大的图片数据集(整个数据集包含1500万张图片,比赛的子集分为1000个类别,每类约1000张),组织方是乐见其成的。

Pascal VOC 2009的分类赛道冠军是NEC与UIUC联队,NEC的负责人是龚怡宏(现任西安交通大学软件学院院长),UIUC的负责人则是对李飞飞有“知遇之恩”的黄煦涛。龚怡宏博士毕业于日本东京大学,从1999年起历任NEC美国研究院硅谷分院项目经理,部门经理,分院院长。2006年,龚怡宏到UIUC黄煦涛组做访问,NEC与UIUC的合作也由此展开。

龚怡宏于2009年离开NEC,接手与UIUC对接合作的是余凯。当时余凯在加州硅谷的NEC美国研究院做部门主管,带领着一个实验室从事计算机视觉和机器学习方面的研究。这个实验室和黄煦涛一直有合作,基本上每年都有他的1、2个学生来NEC实习。

2010年初的一个早晨,黄煦涛从伊利诺伊打电话给还在睡梦中的余凯,询问今年是否能尽量想办法多提供一些资助以支撑博士生的研究。

余凯敏锐地意识到这个电话的非同寻常:以黄煦涛美国工程院院士和计算机视觉泰斗的地位,本是不用担心研究经费的;但当时美国刚刚经历过次债引发的金融危机,黄煦涛应该也受到了不小的波及。

黄煦涛在华人圈子里素以谦卑仁厚闻名,其同事马毅将其称为一位“纯粹的学者”。2006年,龚怡宏代表NEC与他洽谈合作的时候,黄煦涛出人意料地报出了一个和进入学术界不久的助理教授差不多的数字。这次黄煦涛开口,虽然NEC这边经费不是很富裕,但余凯也还是投桃报李,想办法挤出了一笔费用,加大与UIUC的合作力度。

在2010年前后,NEC和UIUC的合作取得了*的成功。黄煦涛的优秀学生,包括杨建朝、周曦、曹亮亮等,被派到NEC实验室,作为实习生参与合作研究。在非监督特征学习方面特别是稀疏编码(Sparse Coding)方向取得重大进展,双方一起合作的CVPR和ECCV论文,至今当年所有CVPR和ECCV会议发表论文中被引用最高的经典论文之列。

在Pascal VOC 2009冠军团队的基础上,NEC-UIUC再度联合组队参加了ImageNet挑战赛。NEC的主力包括林元庆和朱胜火等,UIUC的主力包括周曦和曹亮亮等,余凯、黄煦涛居中协调,当时在罗格斯大学任教的张潼也一同参与其中。

(NEC-UIUC 联队在首届ILSVRC挑战赛冠军团队成员)

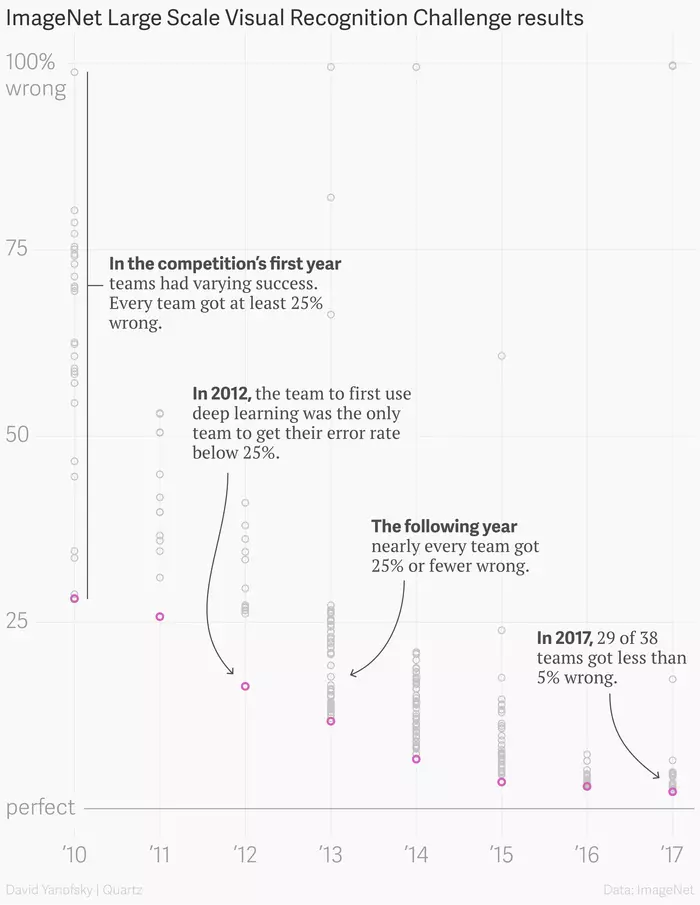

或许是因为是全新的比赛,*届ImageNet挑战赛并未像后世火爆,总共有11个团队提交了结果,而队伍之间的成绩差距巨大,仅有4个团队的错误率低于50%,最后一名提交结果的错误率更是接近99%。相比之下,NEC-UIUC联队28.2%的错误率已经算是一枝独秀,拿下了ImageNet挑战赛的*冠军。

2

爆发:千峰晓色新

如果将数据比作新时代的石油,那么在2010年的ImageNet上,这些数据还只是刚刚被掩埋的生物沉积物而已。但谁也没有想到,仅仅过了两年,它们就已经产生了奇妙的化学变化。

2012年的ImageNet挑战赛上,多伦多大学的Geoffrey Hinton团队凭借全新的深度卷积神经网络结构AlexNet,以压倒性优势夺得了ImageNet冠军。这一突破也使得计算机视觉研究人员开始研究和复现AlexNet,并在随后几年中将深度学习扩展到人工智能的每一个领域。

自此,ImageNet挑战赛开始取代突然停办的Pascal VOC,成为业界竞相追逐、以体现实力的重要指标。

ImageNet历年成绩一览,图片来源:Quartz

言归正传,13年的ImageNet挑战赛上,大多数团队均试图通过复现AlexNet来取得好成绩。这一年大多数队伍的错误率都降到了25%的关口以内,但依然有半数以上的队伍未能超过2012年AlexNet的成绩。

这其中就包括曾被MIT科技评论评为“全球最*计算机科学研究院”的微软亚研(MSRA)。因此2014年的ImageNet挑战赛对MSRA来说颇有点“荣誉之战”的意思,这一年代表MSRA出战的,是由孙剑领衔的视觉计算组。

当时在MSRA做深度学习研究的人并不多,孙剑将研究和复现AlexNet的重担交到了自己指导的*个深度学习博士生张祥雨手中。张祥雨本科就读于西安交大软件学院,编程能力很强,而且还是*一个会CUDA的人。来到微软亚研视觉计算组后,孙祥雨也凭借这一特长参与到多个项目中。

张祥雨花了两个月的时间完成了AlexNet的复现。由于作者开源的代码可读性太差,基本不可用,因此张祥雨不得不自己重新从底层代码做起,还自己写了一个深度学习的框架。后来2013年底Caffe发布,张祥雨参考了Caffe的很多框架设计理念,对自己的代码进行了进一步优化,新的框架不仅具有了多卡协同计算的能力,还支持图优化和同计算策略,这也为之后构建更大更深的神经网络打下了基础。

2014年春节过后,张祥雨对框架的优化告一段落,孙剑也开始招募参加ImageNet挑战赛的人员。

当时微软亚研视觉计算组大多数人的兴趣点还是在更容易出成绩的人脸识别上,最终找来的是对新事物感兴趣的何恺明——当初顶着高考状元光环的何恺明头两年到微软亚研实习的时候也做过不少各种各样的课题,但一直发不了论文;然而不鸣则已一鸣惊人,他在2009年的*篇论文就拿下了*个CVPR*论文。这一次,何恺明希望把传统视觉中的空间金字塔池化(Spatial Pyramid Pooling,SPP)用到深度学习中,跟着何恺明做项目的任少卿也被调了过来。

于是在2014年4月,后来名震天下的ResNet四人组正式“成团”。具体分工上是任少卿做检测、张祥雨做分类,何恺明出方案和做验证,孙剑则负责总体进程的协调。

小组旋即对13年的冠军方案ZFNet进行了研究。当时在13年的时候大家已有把网络模型做深的共识,而ZFNet的卷积网络只有五层,何恺明在RCNN的作者Ross Girshick的启发下提出了SPPNet,SPPNet 本质上是RCNN的升级版本,引入了 2 个重要的概念,即SPP 层,以及对特征量只计算一次,从而提升了 RCNN 的速度。

加了一层SPP层的神经网络果然性能好了很多,但到七层的时候已经很难训练、八层就彻底不收敛了。不过,这个不够*的网络也让小组在14年的ImageNet上拿到了第三,四人撰写的SPPNet的论文也被ECCV接收。而在之后的2015年,SPPNet又启发Ross创作了Fast RCNN,Fast RCNN继续启发何恺明提出了Faster RCNN,这是后话。

14年的比赛结束后,小组又开始研究14年的优胜模型GoogleNet以及另一个模型VGGNet,相比起2013年,神经网络深度又加深了,VGG是19层,GoogleNet是22层。

由于GoogleNet比较复杂,所以小组一开始研究的是VGG,在研究VGG的时候张祥雨意识到不收敛可能跟梯度消失有关,于是推算了一个公式,解决了收敛问题。这个初始化的方法当时在微软内部以张祥雨的名字命名,之后又经历团队合作改善,最终成为常用的线性层的默认初始化方法。

虽然解决了收敛的问题,但离“水论文”却略显不足。小组将目标定在了“错误率低于人类(5.1%)”的里程碑上,这一过程中的主要竞争者是百度的吴韧团队,通过不断加宽和加深网络,最终在2015年春节前,四人小组*次将错误率降到了低于人类的4.96%,这时团队将这一成果整理出来发了一篇论文,在圈内引起了不小的反响。

但小组并不满足于此,因为这次突破更多的是依赖于调参和堆模型,要想更进一步,必须采用新的方案。

这个时候四人小组注意到一件事:虽然GoogleNet的结构更为复杂,但计算量比VGG要低很多。于是,小组的研究重心开始转到了GoogleNet上。

张祥雨尝试将GoogleNet进一步简化,将5x5的卷积层和3x3这几个支路比较复杂的卷积层都去掉,发现对结果影响不大,这说明剩下来的1x1的卷积层才是关键;GoogleNet的性能更多的是依赖于神经网络的深度,同时网络中又有一条足够短的短路联结“Shortcut”,使得网络深度加深的同时仍然易于训练。

基于这一思路,张祥雨又设计了若干个新的模型并进行了实验,也取得了一些不错的结果。但何恺明一直不满意,认为这些模型仍然太复杂,没有找到本质。

在与何恺明商议之后,张祥雨决定构建一个将“Shortcut”和深度都做到*的模型:能不能把“Shortcut”做到尽可能短,同时把最深的路无限的加深?

在这种“极简”思想的指导下小组又做了一系列的实验,甚至去掉了他们之前认为“非常关键”的1x1卷积层。去掉卷积层之后性能确实有些下降,但何恺明认为网络的简洁是最重要的,性能的下降可以通过其他手段来弥补,最终敲定了这个方案。

这个最短路没有任何参数、层数为0的模型就是ResNet。在2015年的ImageNet挑战赛上,四人小组将包括ResNet在内的11个模型“组装”成了一个152层的“超深”神经网络,并在所参加的五个赛道比赛中横扫对手,获得冠军。

如果说2012年的AlexNet开启的是深度学习从0到1的时代,那么2015年的ResNet开启的则是从1到无限可能的新时代。还是套用石油的比喻,从这一刻起,石油不再只被用来燃烧取暖照明,而是被加工和分解组合成新的化工产品,真正成为现代工业的新原料。

3

收官:曲终人不散

2017年的一天,ImageNet挑战赛的参赛队伍从官网看到了关于挑战赛最重要的一条公告:2017年的ImageNet挑战赛将是最后一届。和此前停办的Pascal VOC一样,在举办八年后,ImageNet挑战赛也即将划上句号。

尽管有些突然,但很多人都有预感,这一天迟早会到来。

ImageNet的一个特点是在分类中的每一个图像中都标注了一个主要的物体,这也决定了ImageNet数据集主要用于单个物体的分类和定位。从 2010 年以来,每年的ImageNet挑战赛也都会包含图像分类、单物体定位、物体检测三项基本任务。

然而,ImageNet这种给每一个图像只打一个标签的做法不符合现实世界图像的分布特点,存在较大的局限性。实际上,李飞飞之前就有意在2014年比赛后取消某个任务的比赛,但由于产业界的偏爱而未做调整。到2015年,ResNet在图像分类任务上超越人类的精度并贡献了训练深度神经网络的有效方法,这已经几乎宣告了ImageNet挑战赛的终结。

与之前几次比赛一样,在2016年的ImageNet挑战赛中,前一年的优胜方案ResNet也成了各参赛队伍的重点研究对象。虽然这一年的ImageNet挑战赛并没有提出经典的网络模型,但参赛队伍的成绩均有了较大提升,同时由于大家的思路相近,也导致了2016年的ImageNet挑战赛是有史以来成绩最为接近的一届。

在这次挑战赛最出人意料的是国内团队的大放异彩:CUImage(商汤和港中文),Trimps-Soushen(公安部三所),CUvideo(商汤和港中文),HikVision(海康威视),SenseCUSceneParsing(商汤和香港城市大学),NUIST(南京信息工程大学)卷走了六个项目的冠军,如此大面积的丰收是ImageNet举办以来的*次。

但这一年的ImageNet挑战赛也引发了CV圈的诸多讨论,包括:Scence Parsing Challenge和Place Scene Classification两个较新的任务在对使用预训练模型上的争论;大家都在堆模型,很多优胜方案Ensemble Model(模型集成)的工作计算成本太高;拥有更多资源(包括计算资源与人才资源)的大公司不惜堆资源刷榜,偏离了比赛“更好推动计算机视觉研究的创新”的初心,等等。这或许也坚定了主办方在2017年比赛后停办的信心。

实际上,自 2015 年ResNet诞生后,很多研究者都在ResNet的基础上进行了调整和改进,包括康奈尔大学、清华大学和 Facebook 联合提出的 DenseNet、谷歌提出的 MobileNet,以及何恺明本人与Ross Girshick合作提出的ResNext等。

相比起Resnet,ResNext网络结构更为简明,在同等条件下的计算量也比ResNet更少,但在2016年的ImageNet挑战赛中,更强调优雅和效率的ResNext却败给了其他集成模型,仅在一项任务中获得亚军。直到2017年,另一个ResNet的变体、颜水成团队提出的双通道网络 DPN才摆脱了“堆模型”的阴影夺得ImageNet冠军,并将 200 层 ResNet 的计算量降低了 57%。

这并不是颜水成团队*次在ImageNet挑战赛中夺冠。早在2014年的ImageNet挑战赛他就率队拿下了目标检测任务的冠军,这次夺冠的算法采用了他和学生在2013年提出的Network in Network(NIN)网络结构,其核心 1×1 卷积是近年来几乎所有计算机视觉深度学习模型的标准模块,其思想也被后期的 GoogleNet、残差网络(ResNet)等模型所借鉴。

从2010年以来,颜水成已经拿下了10个计算机视觉重要竞赛的冠亚军,其中包括2012年最后一届Pascal VOC竞赛冠军。2012年的ImageNet挑战赛与Pascal VOC一同举办,颜水成现场见证了AlexNet的崛起,从那时起他开始投入到深度学习的研究中来。

颜水成不仅是计算机视觉竞赛的常客,与ImageNet多支优胜队伍也颇有渊源。他博士毕业于北京大学数学系,2001年,颜水成进入微软亚研实习,在时任微软亚洲研究院副院长张宏江指导下展开研究。彼时正是微软亚研的黄金时代,汇聚了一批优秀的实习生,在ImageNet挑战赛中拿到冠军的余凯、孙剑,正是当年与颜水成一同在微软亚研“青训”的“队友”。

2006年,颜水成又前往UIUC黄煦涛门下做博士后研究。黄煦涛对颜水成的影响颇大,颜水成在刚获得在新加坡国立大学的*份教职时曾向黄煦涛请教怎样成为一个优秀的教授,黄煦涛的回答是“Just be yourself”,好的教授各有不同的方式,非常的简单。颜水成便从自己的特长出发,主攻ICCV和CVPR两大CV顶会和参与计算机视觉竞赛,定下了“6年每年每个顶会发6篇文章”的目标。到他2015年前往产业界之时,他带领的新加坡国立大学机器学习与视觉实验室(NUS-LV)已经是世界*的计算机视觉团队之一。

2017年的DPN便是颜水成去往产业界、结合产业落地“低能耗”需求的产物。所谓的双通道,其中一条通道是ResNet,另一通道是DenseNet。通过对ResNet和DenseNet分析两个模型的优劣,将两个模型有针对性的组合起来的又一经典基础模型。在他看来,相比刷榜取得好的名次,是否能通过比赛验证有价值的想法更为重要,通过ImageNet挑战赛而为人熟知的基础模型,包括AlexNet、GoogleNet、VGG、ResNet和DPN等,都会对计算机视觉社区产生长远的影响。

对于ImageNet挑战赛的落幕,颜水成同样表示,每一个比赛都承载了大家对技术发展的期望,而在技术进步的过程中,大家也会逐渐发现这些数据库的局限性。ImageNet挑战赛虽然结束,但当中的一些任务如物体检测方面的相关研究,也还会继续下去。

曲终,但人不散。

一个时代有一个时代的主题,一代人有一代人的使命。短短12年一纪间,人工智能与计算机视觉研究便发生了翻天覆地的变化。而这一切,都要从李飞飞2006年,对大规模数据集最初的想法开始——

如果当初对ImageNet的最初想法是看到了一颗宝石,其后整个ImageNet挑战赛,不过是弯腰去拾取它罢了。

4

尾声:相望意悠悠

2017年7月,太平洋上的小岛、旅游胜地檀香山(Honululu)迎来了来自世界各地的5000余名计算机视觉研究者,计算机视觉的*学术会议CVPR在此拉开序幕,而最后一届ImageNet挑战赛的Workshop,也将在CVPR 2017上举行。

7月26日,ImageNet挑战赛Workshop召开,李飞飞进行了题为《IMAGENET—Where have we been?Where are we going?》(ImageNet:我们来自何方,我们去向何处)的演讲,回顾了ImageNet从2010年首次举办以来的8年历程。

(李飞飞《IMAGENET—Where have we been?

Where are we going?》演讲PPT截图)

李飞飞认为,ImageNet对AI研究*的贡献是改变了人们的思维模式。越来越多的研究者意识到,数据——而不是模型——可能是迈向人类水平的人工智能过程中的关键因素。“数据重新定义了我们对模型的思考方式。”她说。

她同时还表示,尽管 ImageNet 挑战赛结束了,但 ImageNet 数据集的维护和相关研究仍将会继续。在单标签识别问题基本得到解决后,她近几年关注的新方向包括视觉理解、视觉关系的预测等视觉之外的内容,并已经在着手建立相关的数据集。

这或许只是计算机视觉飞速发展的一个缩影——不止李飞飞,ImageNet竞赛的冠军们,同样又瞄准了视觉研究与应用的新赛道,重新出发。

星芒万里,前路漫漫,对于未来的探索永不停止。正如亚瑟·克拉克(Arthur C. Clarke)在《太空漫游 》“人类的登场”一节中的点睛之笔:

人,掌握了过去,接着要探索未来。

One More Thing

本文四节小标题由清华大学“九歌”人工智能诗歌写作系统辅助生成。

参考资料:

1、https://www.youtube.com/watch?v=YE1UDwksAOc

2、qz.com

4、李飞飞在 IJCV 吐露心声:崛起的亚洲 AI 力量伴我成长 | CVPR 2017 | 雷峰网

5、一只龙虾引发的盛宴:CVPR 亚洲人工智能学者聚会 IJCV Asia Night,十位大牛都说了什么?| CVPR 2017 | 雷峰网