趋境科技推出大模型知识推理一体机,采用“以存换算”新思路

随着大模型技术的飞速发展,尤其是在开源大模型的推动下,具备复杂推理能力的模型正逐步渗透到各个行业,展现出超越人类专家的潜力。这一趋势预示着未来的算力建设将更加侧重于推理场景,而非仅仅关注训练算力。

根据华福证券的研究数据,到2027年,推理端的人工智能服务器预计将占据整体工作负载的72.6%。同时,OpenAI的o1大模型推理场景所揭示的Scaling Law进一步加速了这一发展趋势。

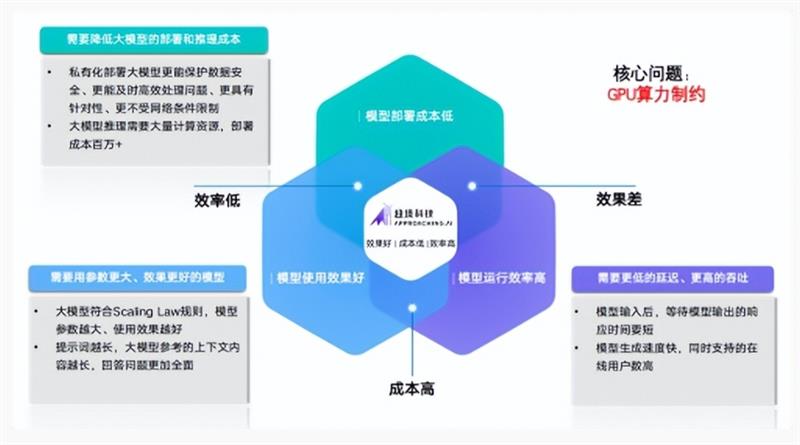

然而,尽管模型效果显著提升,但数百亿参数、上百万上下文的一线模型在实际部署中仍面临高成本和低效率的挑战。这一现象导致了所谓的“不可能三角”困境。为了解决这一问题,迫切需要新型推理架构来打破传统以高端GPU为中心的算力架构设计思路,这种设计主要针对训练场景。

在此背景下,趋境科技推出了“大模型知识推理一体机”。该产品搭载了业界首创的全系统推理架构,能够协同存储、CPU、GPU、NPU等多种设备,充分释放异构算力,将推理成本降低10倍以上。

趋境大模型知识推理一体机不仅支持本地部署数百亿级别的一线大模型,还提供开放的API接口,便于第三方灵活调用。此外,用户还可以根据需求定制企业智能助手(assistant/copilot),实现真正的“开箱即用”。

该产品采用的全系统推理架构通过“以存换算”技术释放存力作为算力的补充,降低对算力的需求;同时采用“异构协同”的思路,紧密联动HBM/DRAM/SSD和CPU/GPU/NPU全系统异构设备,突破显存容量的限制,充分释放全系统的存力和算力。这一创新方案突破了以往方案的理论优化极限,实现了整合机器所有异构算力资源的目标,使得推理吞吐量提升超过10倍,大幅降低了大模型的落地成本。

此外,财通证券发布的行业深度分析报告指出,国产GPU产品在单精度/半精度浮点算力、制程及显存容量上都与英伟达存在2-4倍的显著差距。因此,仅依靠GPU单点优化,短时间内很难赶超英伟达GPU方案。而采用全系统推理架构可以大幅降低GPU性能差距的影响,显著提升国产替代解决方案的竞争力。

趋境科技还创新性地设计了“融合推理(Fusion Attention)”技术,以应对早期大模型推理架构缺乏高效处理所需的“记忆”能力的问题。该技术使得即便是面对全新的问题,也可以从历史相关信息中提取可复用的部分内容,与现场信息进行在线融合计算。这一技术显著提升了可复用的历史计算结果,进而降低了计算量。

通过这一新思路,趋境大模型知识推理一体机充分利用了存储资源,采用“以存换算”的方式释放存力作为对于算力的补充,在RAG场景中,响应延迟降低20倍,性能提升达10倍。

除了通过“以存换算”降低算力需求外,趋境大模型知识推理一体机还进一步通过全系统异构协同架构设计,将来自存储、CPU、GPU、NPU的算力高效融合,进一步提升大模型推理性能,降低成本。

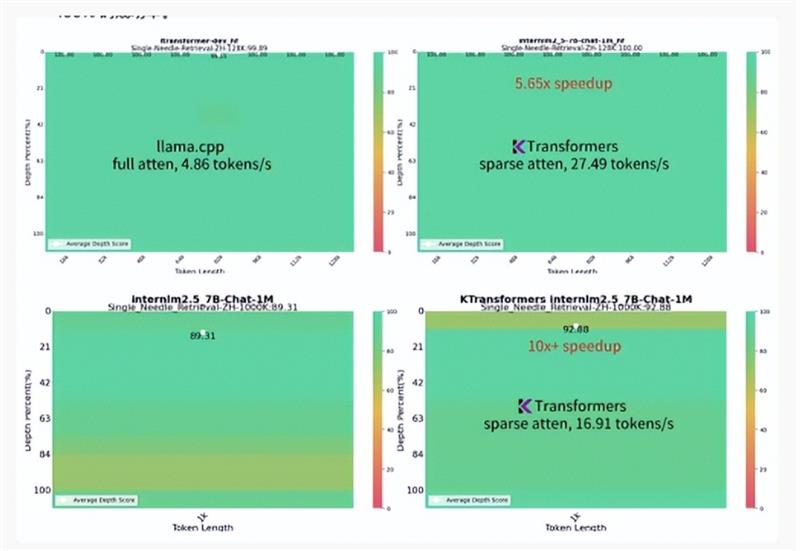

此前,趋境科技与清华KVCache.AI团队合作,开源了一部分异构推理框架,项目名为“KTransformers”。该开源框架仅需单个消费级GPU即可在本地运行Mixtral 8x22B和DeepSeek-Coder-V2等千亿级大模型,性能数倍于Llama.cpp。在长达1M的超长上下文推理任务中,成为业界首 个仅需单GPU卡的高性能推理框架,生成速度达到16.91 token/s,比Llama.cpp快10倍以上,同时维持接近满分的“大海捞针”能力。

趋境科技大模型知识推理一体机采用的全系统推理架构是基于“KTransformers”进一步完善的商业版本,在开源版的基础上,协同性能更强,加入了多卡高并发调度、RAG支持等策略。经过测试及客户合作验证,Prefill和Generate性能显著提升。

网络信息安全公司长亭科技采用了趋境科技提供的全系统异构推理架构技术策略,将其无缝衔接到原有的“问津(ChaitinAI)安全大模型”、MSS安全托管服务等产品中。升级后的问津(ChaitinAI)安全大模型成为千亿大模型,安全性能全面提升: 核心指标攻击识别准确率提升至95.8%,检测时延降低至秒级。 漏洞检测能力增强,发现数量更多,修复建议更准确,能基于不同场景选择合适工具和策略。不良内容识别能力升级,准确率和召回率均有提升,安全报告内容生成质量和评分显著提高,综合输出更具健壮性和稳定性。

此外,长亭科技的安全大模型部署资源成本降低50%,助推其更多业务加入大模型能力。

技术的不断进步和市场需求为大模型的未来发展提供了广阔的空间。随着算力基础设施的不断完善,提升算力的利用效率,使大模型能与更多的行业实践结合起来,未来大模型将在更多行业中发挥更大的作用。

相关资讯

- 一体化多模态介入超声手术室,助力智能化精准微创诊疗

- 复购率超80%,国货新锐设计师潮牌女装开辟抖音电商新主场

- 中建壹品·学府公馆即将交付 它给出怎样的品质答案?

- “智算蓝图,耘领未来”——蓝耘战略&产品发布会盛启在即

- 中小微企业的“融资神器”是什么?深度数科打造票据生态助力行业创新变革

- 乌镇峰会未成年人网络保护论坛举行,腾讯郭凯天:多方共治护航未成年人成长

- 脑洞大开 年轻人双十一用开拍App日更百条短视频带货

- 比克电池占孝云:多款半固态电池产品通过针刺试验

- 可心柔签约刘诗诗为首 位全球品牌代言人,温柔携手呵护相伴

- 蒙特安维精品公寓琢岸阁典藏初绽,于伦敦南岸品味小众奢雅生活

- 汇聚关爱之力,从心出发——华润紫竹药业绘就女性健康新篇章